К концу года OpenAI будет насчитывать миллион ускорителей для обучения ChatGPT

Кажется, про искусственный интеллект никто не собирается забывать, совсем даже наоборот — разработчики крупнейших и умнейших моделей предпочитают продолжать инвестировать огромные суммы в развитие своих детищ, увеличивая и без того высокий спрос на ускорители высокопроизводительных вычислений.

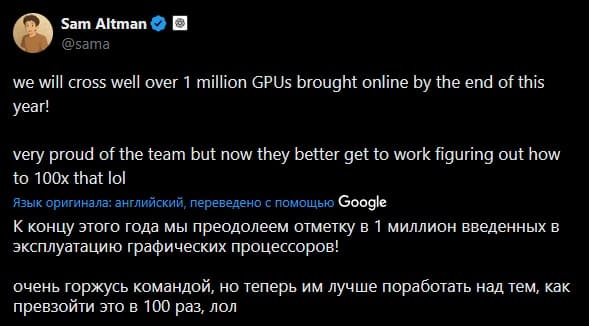

Генеральный директор OpenAI Сэм Альтман (Sam Altman) опубликовал очень краткое, но интересное сообщение, согласно которому компания якобы планирует увеличить количество ускорителей для обучения ChatGPT до одного миллиона. Для справки: Grok 4 от X, одна из умнейших нейросетей, была обучена при помощи 200 тысяч ускорителей NVIDIA H100. Вот и делайте выводы.

Но перед получением такого количества ускорителей необходимо решить несколько проблем. Во-первых, их стоимость будет очень высокой и сильно зависеть от модели: если, к примеру, взять ценник $30 тысяч за штуку, то OpenAI придётся найти $30 миллиардов. Во-вторых, производственных мощностей NVIDIA, TSMC и их партнёров попросту не хватит для выполнения столь крупного заказа — разве что придётся приобретать и новые, и бывшие в употреблении ускорители. Возможно, даже разные модели.

В-третьих, такое количество ускорителей потребует огромного количества энергии, подавать которую будет очень сложно без создания новых электростанций в том месте, где они будут располагаться, а это дело далеко не самое быстрое.

Более того, в будущем Сэм планирует увеличить количество ускорителей до 100 миллионов и уже сейчас предлагает своим работягам подумать над тем, как это можно реализовать.