Ускорители NVIDIA позволили снизить стоимость обучения ИИ с $10 миллионов до $400 тысяч

NVIDIA продолжает акцентировать внимание на искусственном интеллекте, представляя новые продукты, новые технологии на его основе и для его обучения. На выставке Computex 2023 генеральный директор NVIDIA в лице Дженсена Хуанга (Jensen Huang) рассказал, как компании удалось серьезно снизить стоимость обучения одной большой языковой модели (Large Language Model).

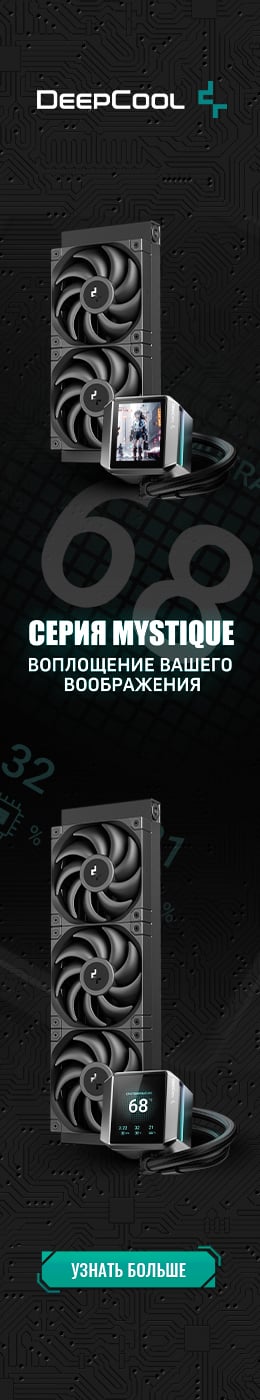

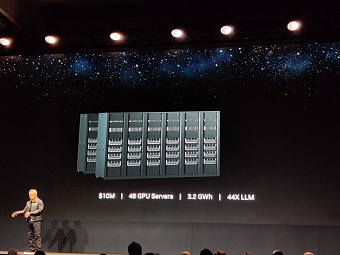

Он утверждает, что при использовании серверных центральных процессоров, для обучения одной большой языковой модели, необходимо задействовать 960 процессоров, потреблять 11 ГВт и потратить $10 млн с учетом коммутаторов, стоек и прочего оборудования. Решения NVIDIA на основе графических ускорителей позволяют значительно изменить эти показатели. Например, если ограничиваться тем же бюджетом, то можно использовать 48 ускорителей, потребление которых не превысит 3.2 ГВт, при этом этого будет достаточно для обучения не 1, а 44 LLM.

Если же говорить про систему с таким же потреблением, как в случае серверных процессоров, то можно использовать 172 ускорителя с ценником $34 млн и обучить 150 LLM. Для обучения одной большой языковой модели потребуется всего лишь 2 ускорителя, 0.13 ГВт энергии и $400 тысяч, что значительно дешевле $10 миллионов в случае серверных процессоров.

Таким образом, NVIDIA продолжает продвигать свою продукцию в сфере искусственного интеллекта, демонстрируя свои преимущества над конкурентами и предлагая партнерам несколько вариантов бюджета, потребления и производительности.