AMD Infinity Fabric 3.0: маленький интерконнект для больших целей

Компания AMD использует интерконнект Infinity Fabric со времён первого поколения процессоров Ryzen на микроархитектуре Zen. В настольных процессорах она соединяет несколько чиплетов между собой и c кристаллом ввода-вывода, а тактовая частота привязана к рабочей тактовой частоте оперативной памяти.

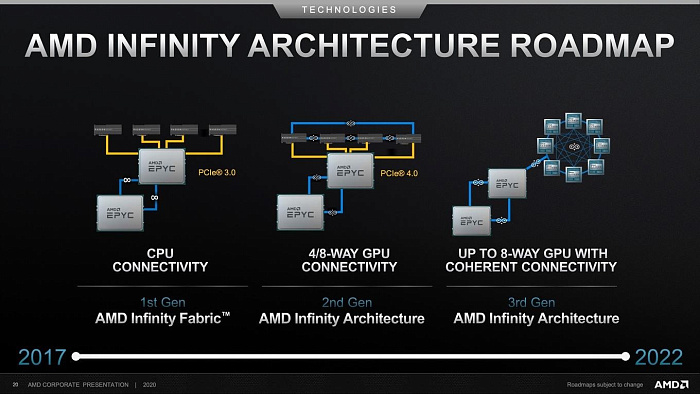

Вместе с серверными процессорами AMD EPYC Milan-X, Genoa и Gergamo, а также ускорителями высокопроизводительных вычислений Instinct MI200, компания представила третье поколение интерконнекта Infinity Fabric. В серверном сегменте он используется для соединения чиплетов центральных процессоров между собой и с кристаллом ввода-вывода, но теперь он будет использоваться и для соединения графических чиплетов, и даже для создания целой сети.

Отныне в серверном сегменте интерконнект AMD Infinity Fabric будет соединять серверные процессоры AMD EPYC с графическими ускорителями Instinct MI200, которые получили возможность объединения в единую сеть, состоящую из двух центральных процессоров и восьми ускорителей. Ранее они соединялись между собой при помощи некогерентного интерфейса PCI Express, ограничиваясь его пропускной способностью, теперь за это будет отвечать Infinity Fabric.

Если пиковая пропускная способность интерфейса PCI Express 4.0 составляет 32 Гбита/с при использовании 16 линий, то AMD Infinity Fabric 3.0 предлагает пропускную способность 100 Гбайт/с на один канал, в то время как их восемь, то есть 800 Гбайт/с, что существенно больше того, чем предлагает PCI Express.

По сути, новая версия интерконнекта AMD Infinity Fabric предлагает согласованный канал связи не только между несколькими процессорами EPYC, но и между восемью ускорителями Instinct MI200, создавая единую сеть, а также значительно увеличенную пропускную способность, что явно не будет лишним в серверном сегменте.