Обзор и тестирование видеокарты AMD Radeon RX Vega 56

Для широко известнойкомпанииAdvanced Micro Devices 2017 год можно назвать прорывным. После долгого застоя на рынке высокопроизводительных процессороввсего за несколько месяцев AMDудалось удачно ворваться в настольный сегмент с процессорами AMD Ryzen 3, Ryzen 5 и Ryzen 7, а также освоить новую область - HEDT с помощью мощных процессоров AMD Ryzen Threadripper. Но это не стало конечной остановкой - в дополнение к видеокартам Polaris, покрывающим начальный и средний уровень игровых видеоадаптеров, подключилась тяжелая артиллерия в лицеAMD Radeon RX Vega 64иRadeon RX Vega 56, подробные видеообзоры которых вы можете увидеть ниже.

Однако, за кадром остались некоторые моменты:прошивка BIOS от старшей видеокарты вRadeon RX Vega 56, работа AMD CrossFireXна новых графических решениях, технология HBCC. Сегодня мы сделаем акцент на этих деталях и узнаем, чем же так интересна видеокартаAMD Radeon RX Vega 56.

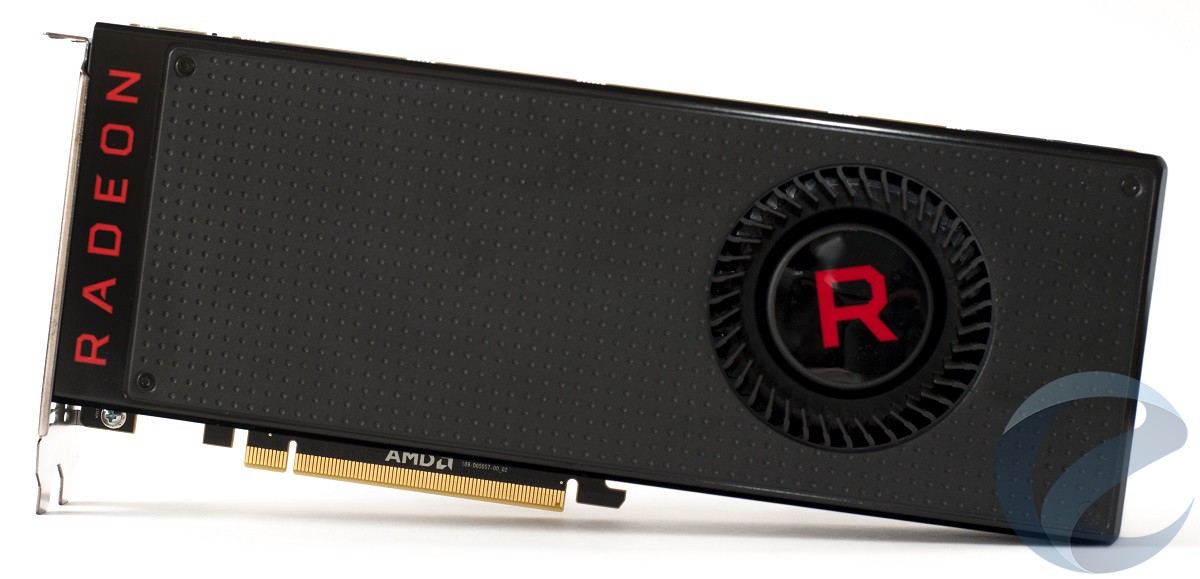

Дизайн видеокарты

Дизайн видеокарты нам уже знаком по предыдущим обзорам. Стоит отметить, что в наших руках побывала только обычная серия, но есть еще ограниченные издания с кожухом стального цвета, а также с использованием замкнутой системы жидкостного охлаждения вместо привычной для референсных карт турбиной.

В руках видеокарта чувствуется единым целым, кожух придает карте массивности. Лицевая часть выделяется только надписью RADEON и вентилятором.

Обратную сторону покрывает металлическая защитная пластина, которая,по ощущениям,может выдержать и удар молотком.

Еще одна надпись RADEON, находящаяся на торце видеокарты, имеет подсветку красного цвета. Ничего лишнего, лишь два 8-pin разъема дополнительного питания бросаются в глаза.

Сами защелки разъемов расположены внутрикожуха, но это не создает никаких проблем при подключении и отсоединении кабеля питания. Над разъемами расположены светодиоды GPUTach, которые сигнализируют о загрузке графического процессора (8 светодиодов) и о режиме работы (крайний слева).

Небольшой переключатель расположен ближе к панели видеовыходов видеокарты.

Это переключатель BIOS, который имеет два положения - основной BIOS, который можно заменить на свою версию (левое положение), а также резервная версия BIOS с уменьшенными лимитами потребления и с защитой от записи (правое положение).

Технические характеристики и особенности видеокарты

| Наименование | AMD Radeon RX Vega 56 |

| Графический процессор | Vega 10 XL |

| Архитектура | Graphics Core Next (GCN) 1.4 |

| Техпроцесс | 14 нм FinFET |

| Базовая тактовая частота | 1156 |

| Тактовая частота с ускорением | 1471 |

| Количество шейдерных ALU | 3584 |

| Количество текстурных блоков | 224 |

| Количество блоков растеризации | 64 |

| Тип памяти | HBM2 |

| Быстродействие памяти | 1600 Мбит/с |

| Полоса пропускания шины памяти | 2048 бит |

| Объем памяти | 8192 МГб |

| Дополнительные разъемы питания | 8+8 pin |

| Потребляемая мощность | 210 Вт |

| Видеовыходы | HDMI 2.0 (1 шт), DisplayPort 1.4 (3 шт) |

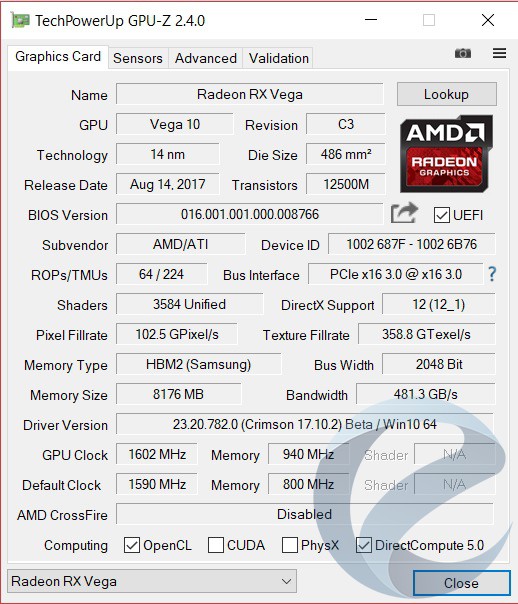

ВидеокартаAMD Radeon RX Vega 56поставляется с версией BIOS 016.001.01.000.008766в роли основнойи016.001.01.000.008767- в роли резервной.

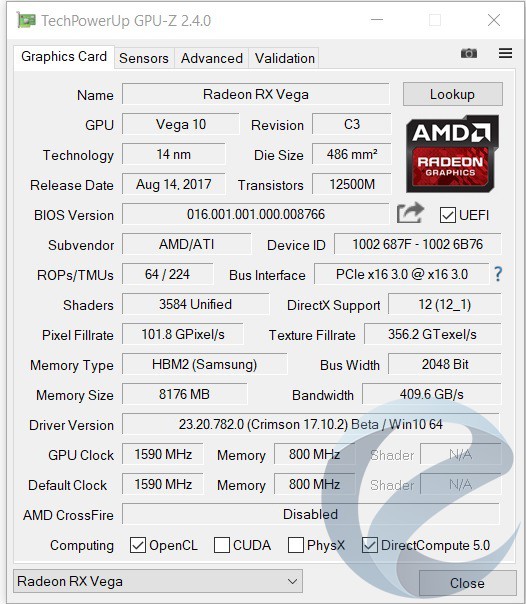

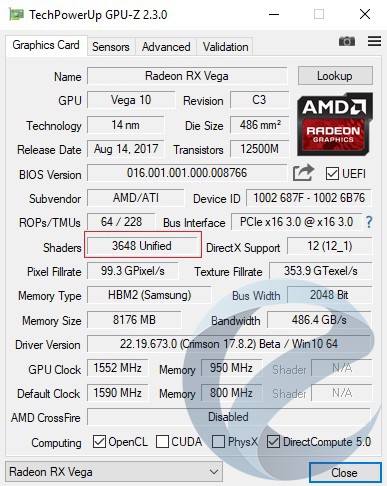

Частота графического процессора указзывается как 1590 МГц в программеTechPowerUp GPU-Z, частота памяти - 800 МГц (1600 МГц эффективная). Пропускная способность памяти достигает 409,6 Гбит/с, что для нового типа памяти с такой шиной кажется несколько малой величиной.

Тестовый стенд

- Материнская плата: ASUS X99-A II (BIOS 1701);

- Процессор: Intel Core i7-5960X Extreme Edition «Haswell-E» 3000 МГц с разгоном до 4600 МГц при напряжении 1.28 В;

- Система охлаждения: самосборная СЖО;

- Термоинтерфейс: Gelid GC-Extreme;

- Оперативная память: 4 x 8 Гбайт KFA2 HOF Hall Of Fame 3200 МГц (HOF4CXLBS4000M19SF162K; 14-14-14-28 CR1);

- Видеокарта: AMD Radeon RX Vega 56 8 Гбайт HBM2;

- Блок питания: Corsair RM1000i мощностью 1000 Ватт;

- Системный накопитель: SSD Samsung 850 Evo 250 Гбайт;

- Корпус: Fractal Design Define S Window Black.

Программное обеспечение:

- Операционная система: Windows 10 x64 «Профессиональная» со всеми текущими обновлениями с Windows Update;

- Драйвер видеокарты: Radeon Software Crimson ReLive Edition 17.10.3.

Тестирование системы охлаждения и разгон

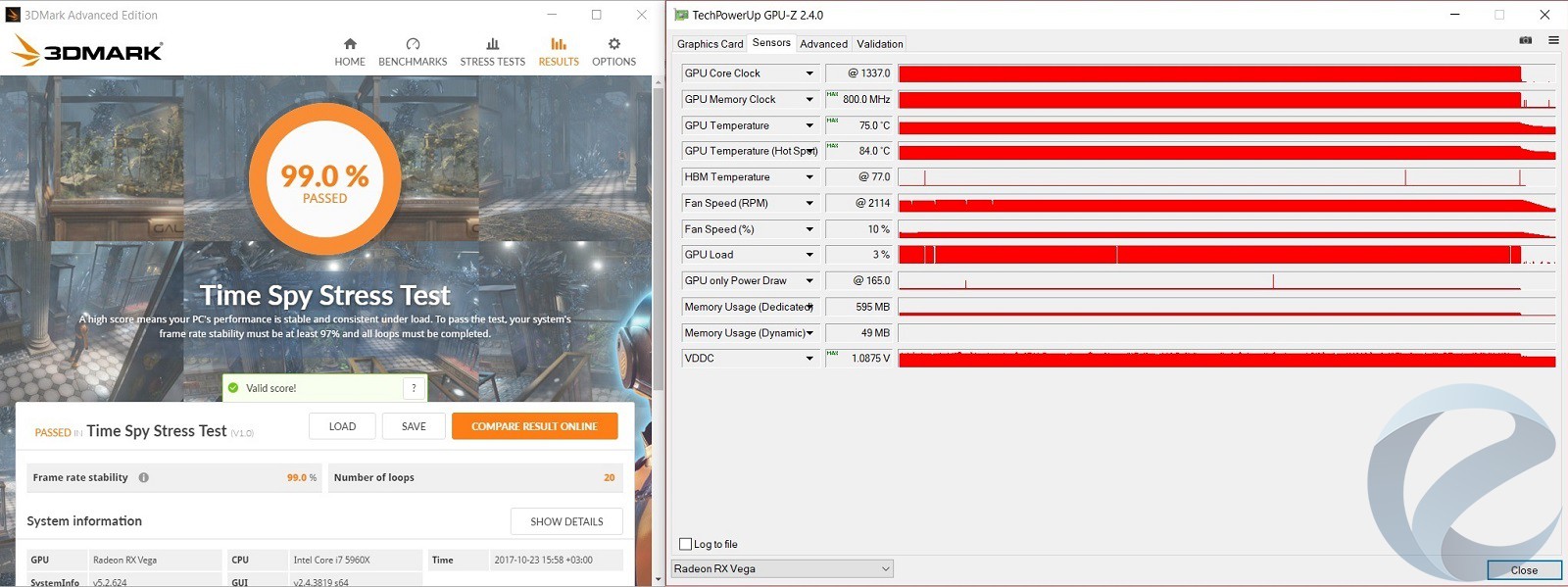

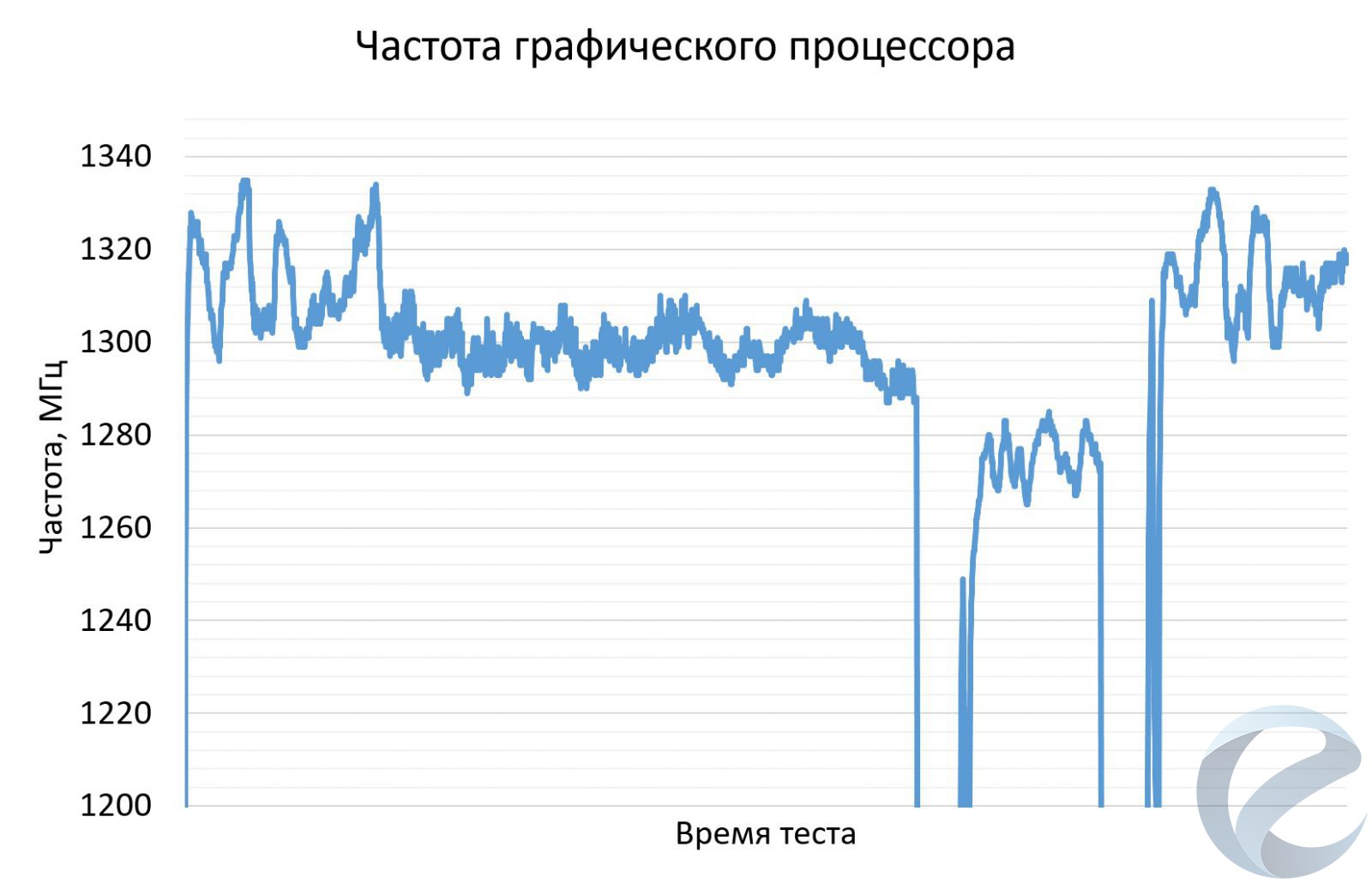

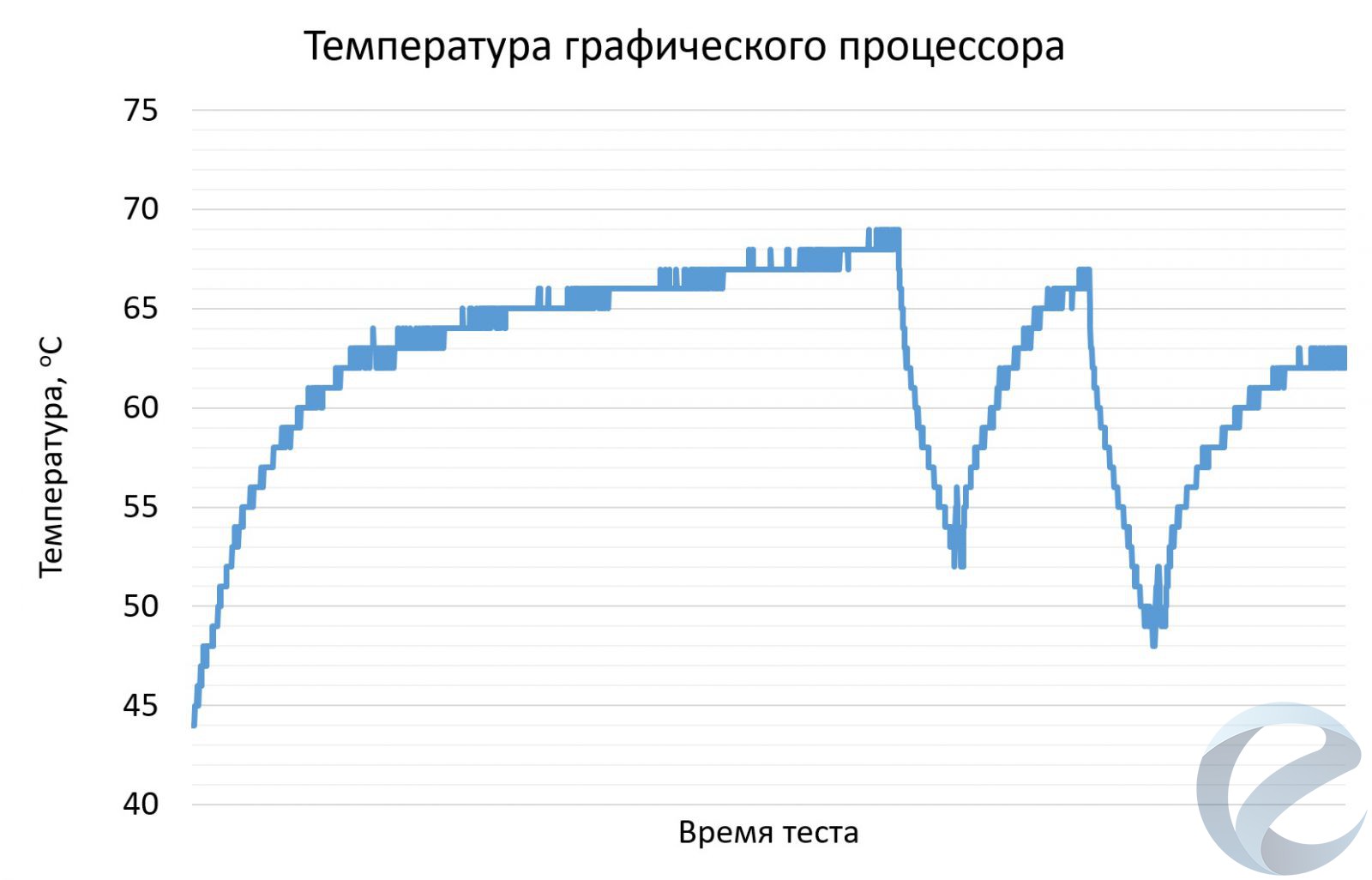

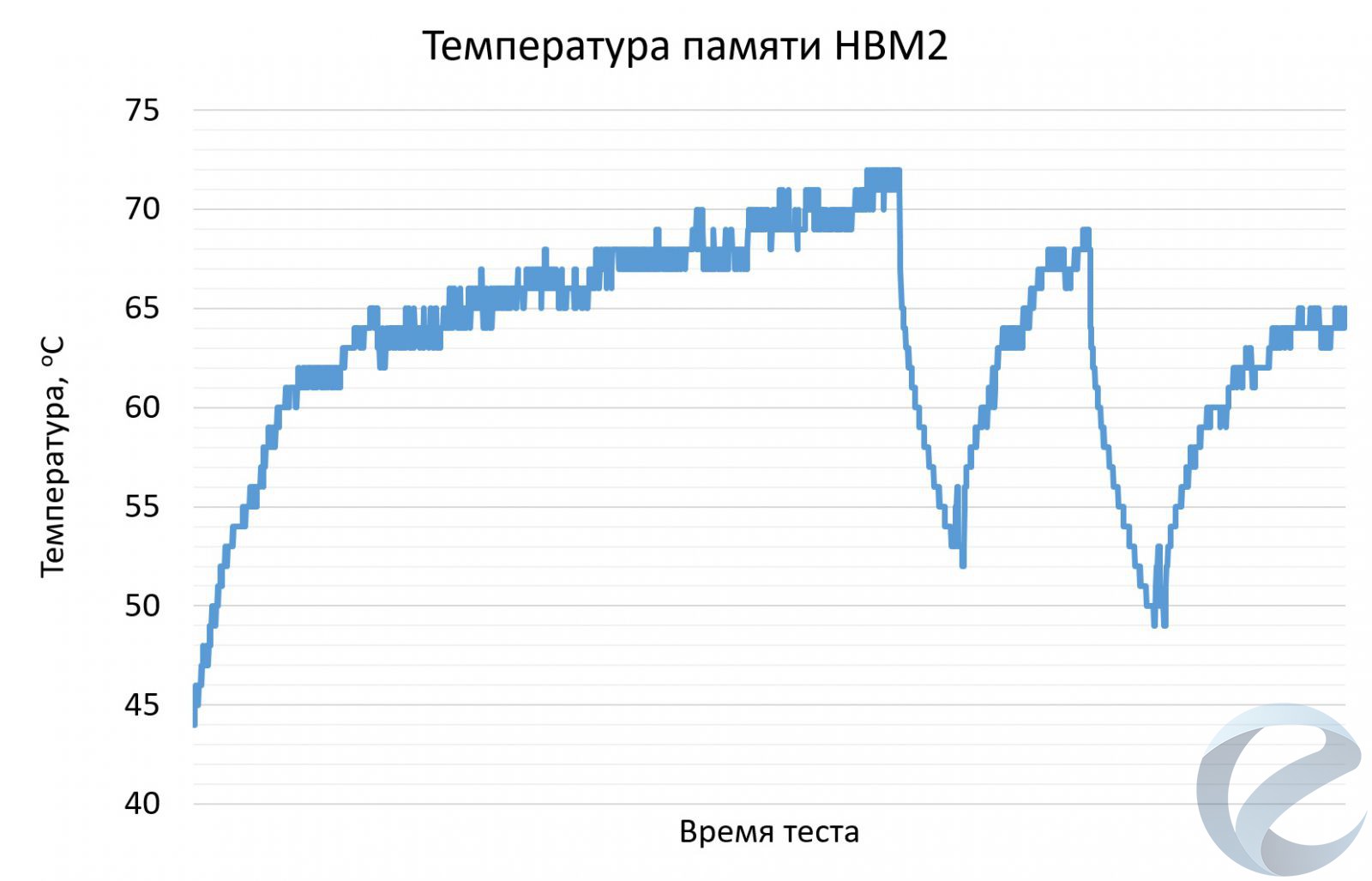

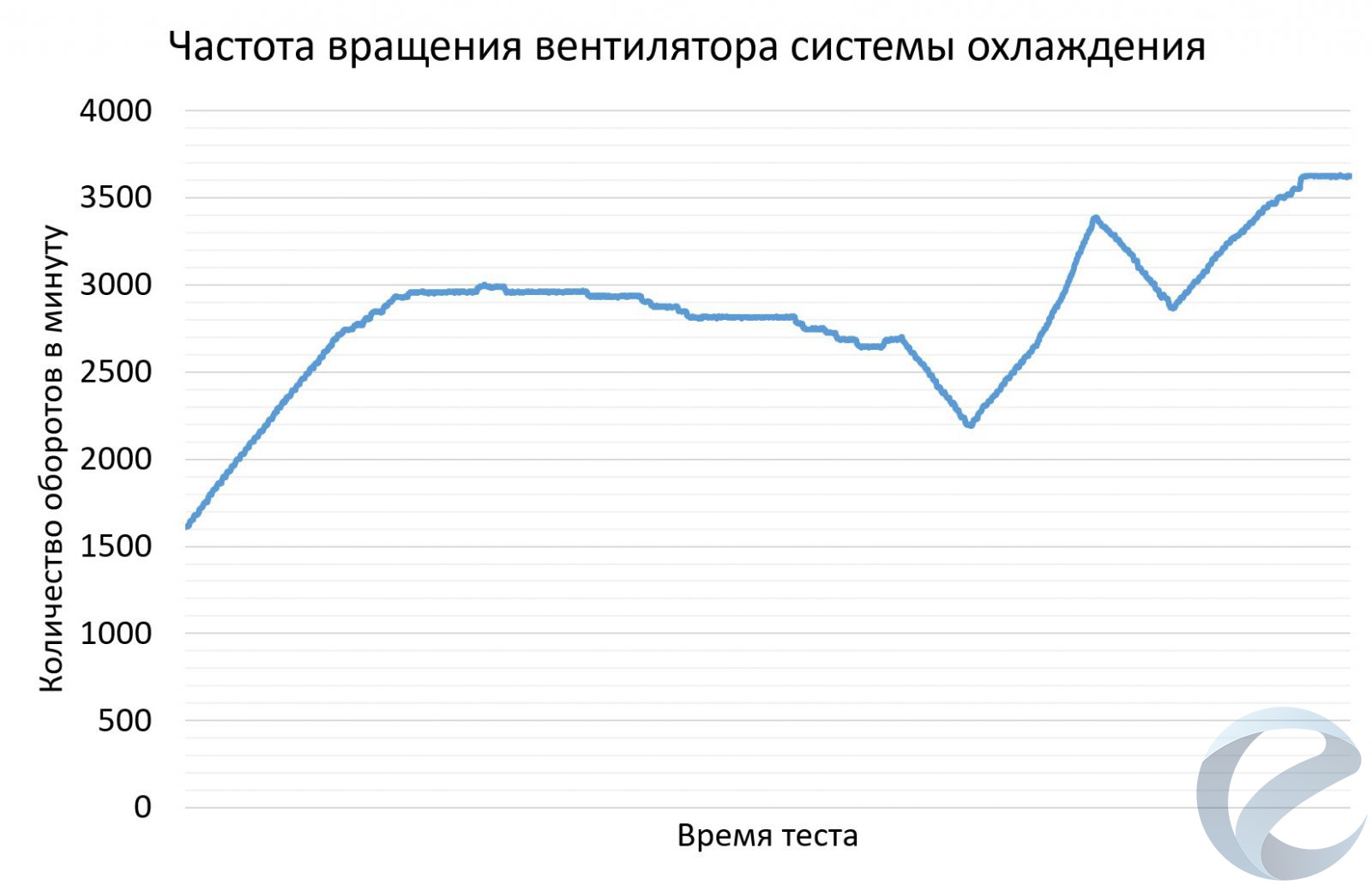

Тестирование системы охлаждения проводилось в тесте устойчивости Time Spy из пакета Futuremark 3DMark. Комнатная температура находилась в диапазоне 24-26 оС, боковая крышка корпуса была закрыта.

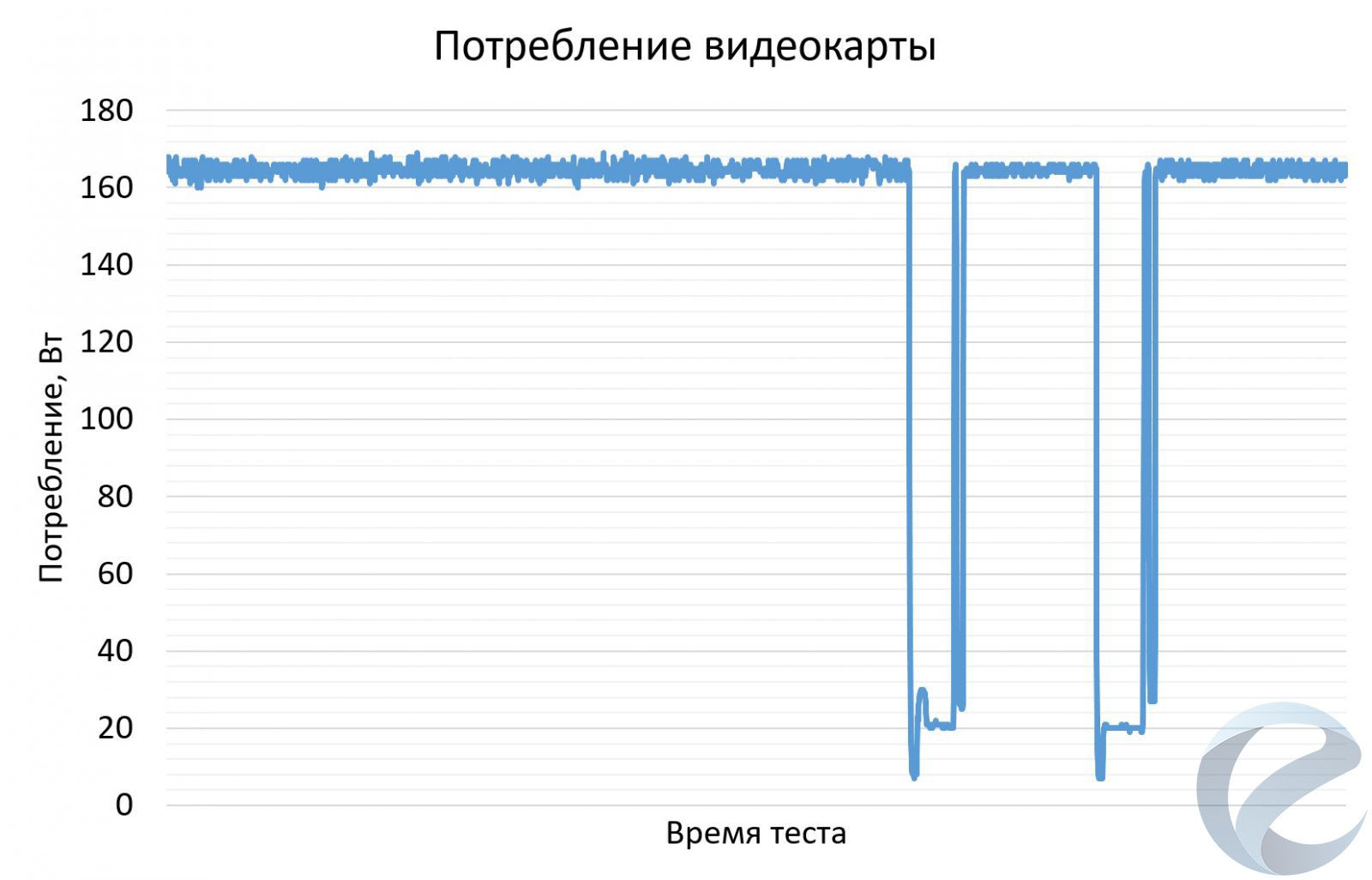

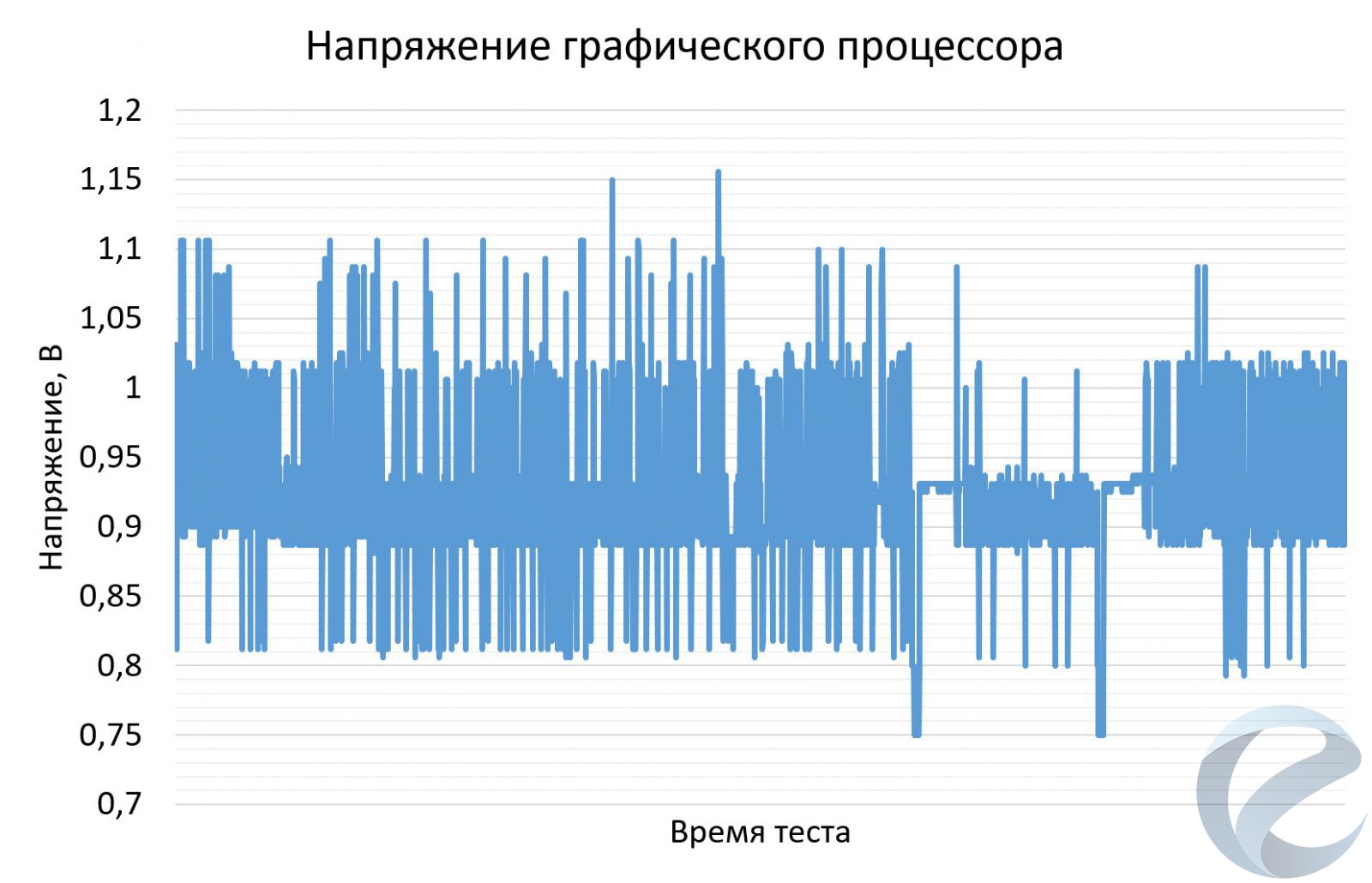

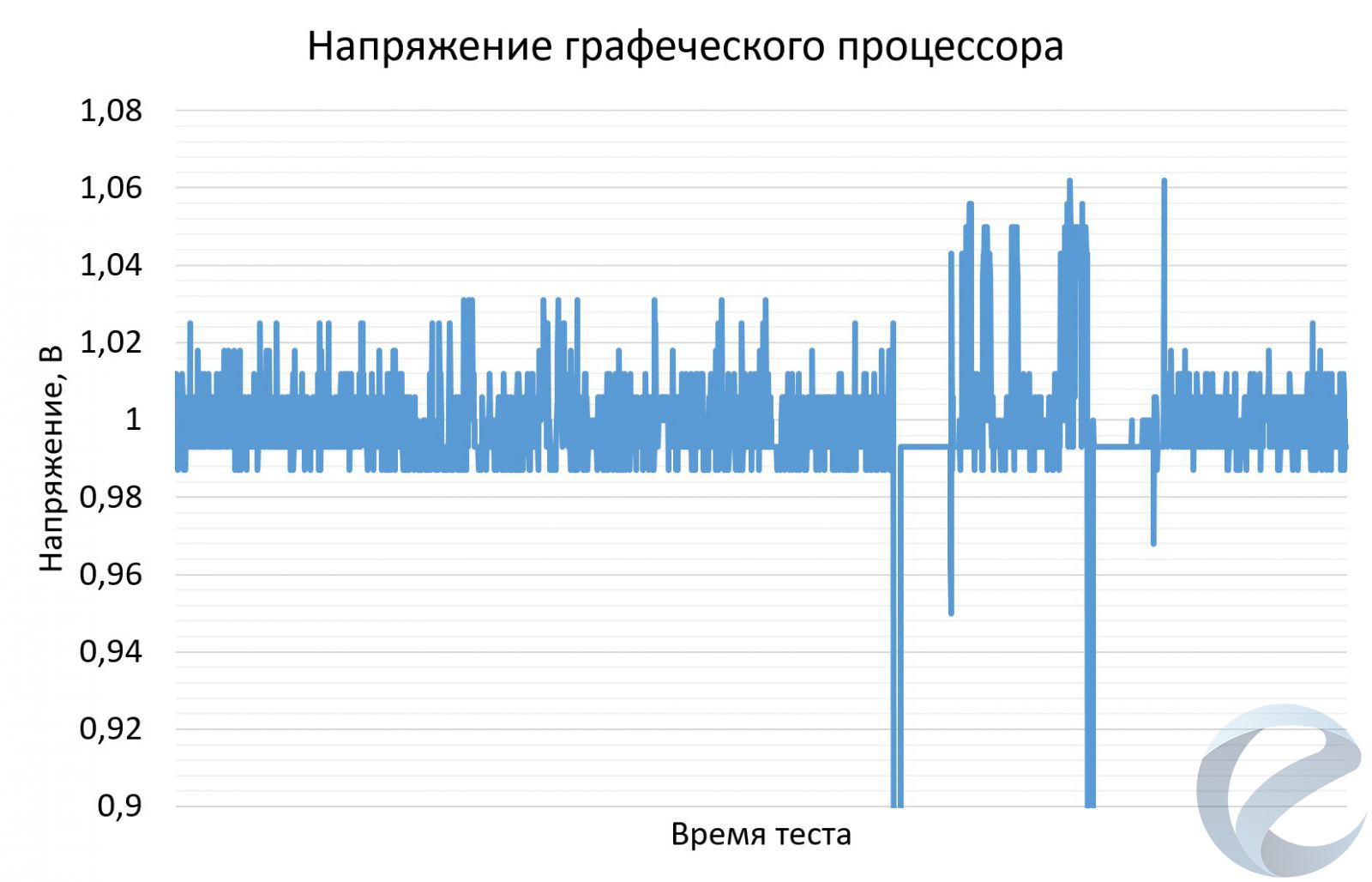

На полностью заводских настройках видеокарта упиралась в лимит мощности, зашитый в BIOS. К концу теста частота графического процессора находилась на уровне 1337 МГц, а максимальное напряжение достигало 1.0875 В. Частота памяти HBM2 находилась на отметке 800 МГц (1600 МГц эффективная), что соответствует паспортным значениям.

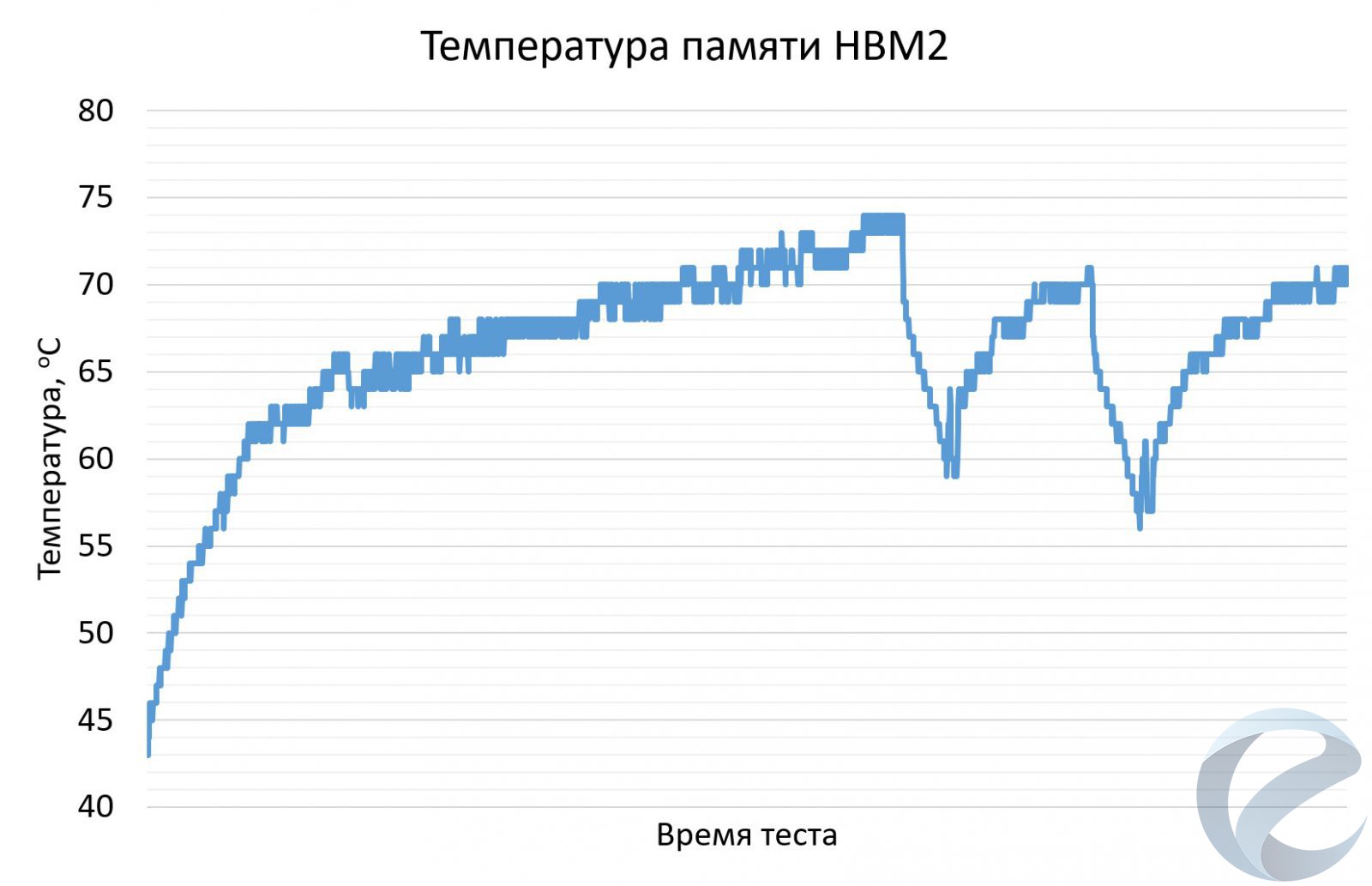

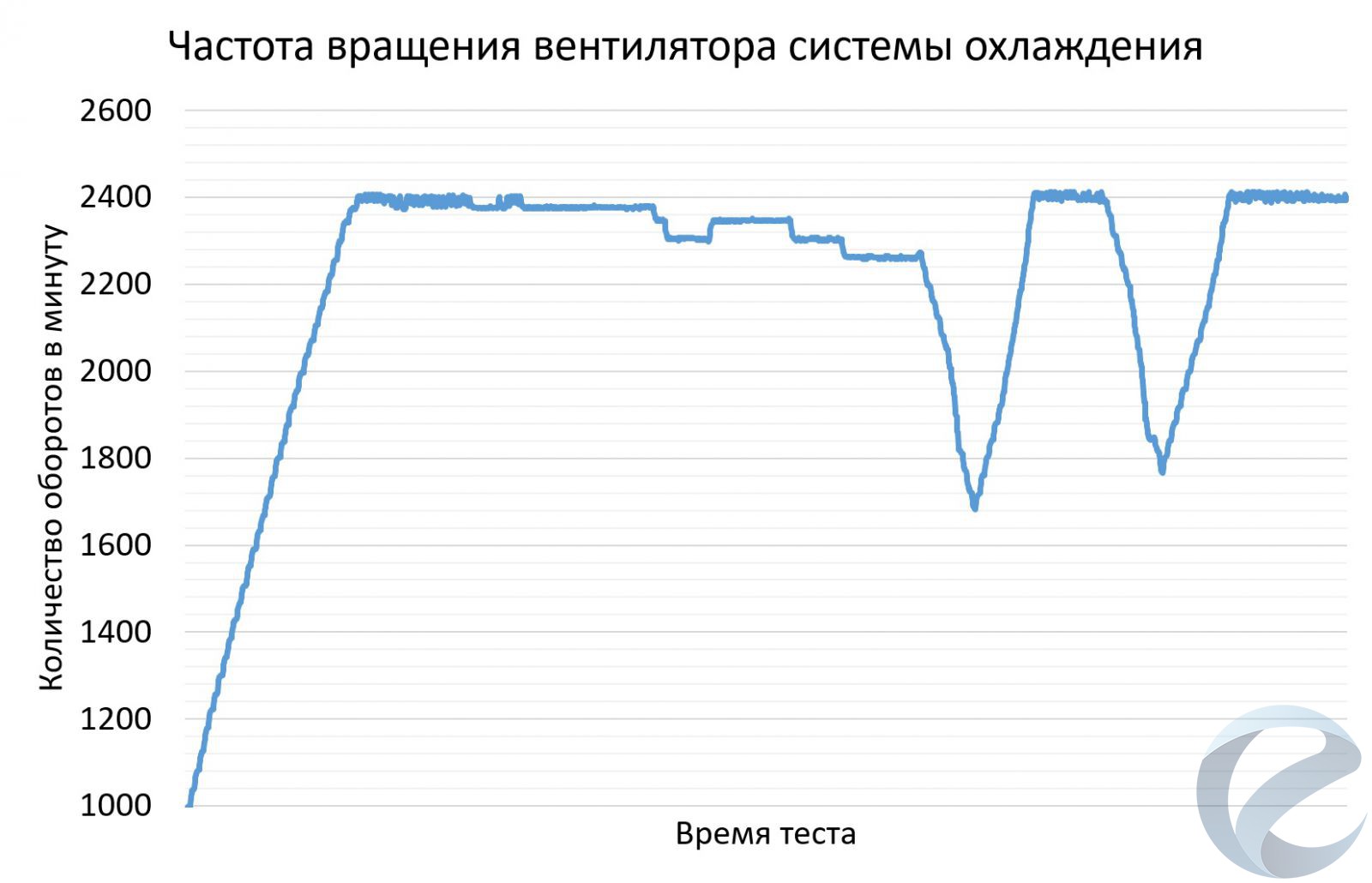

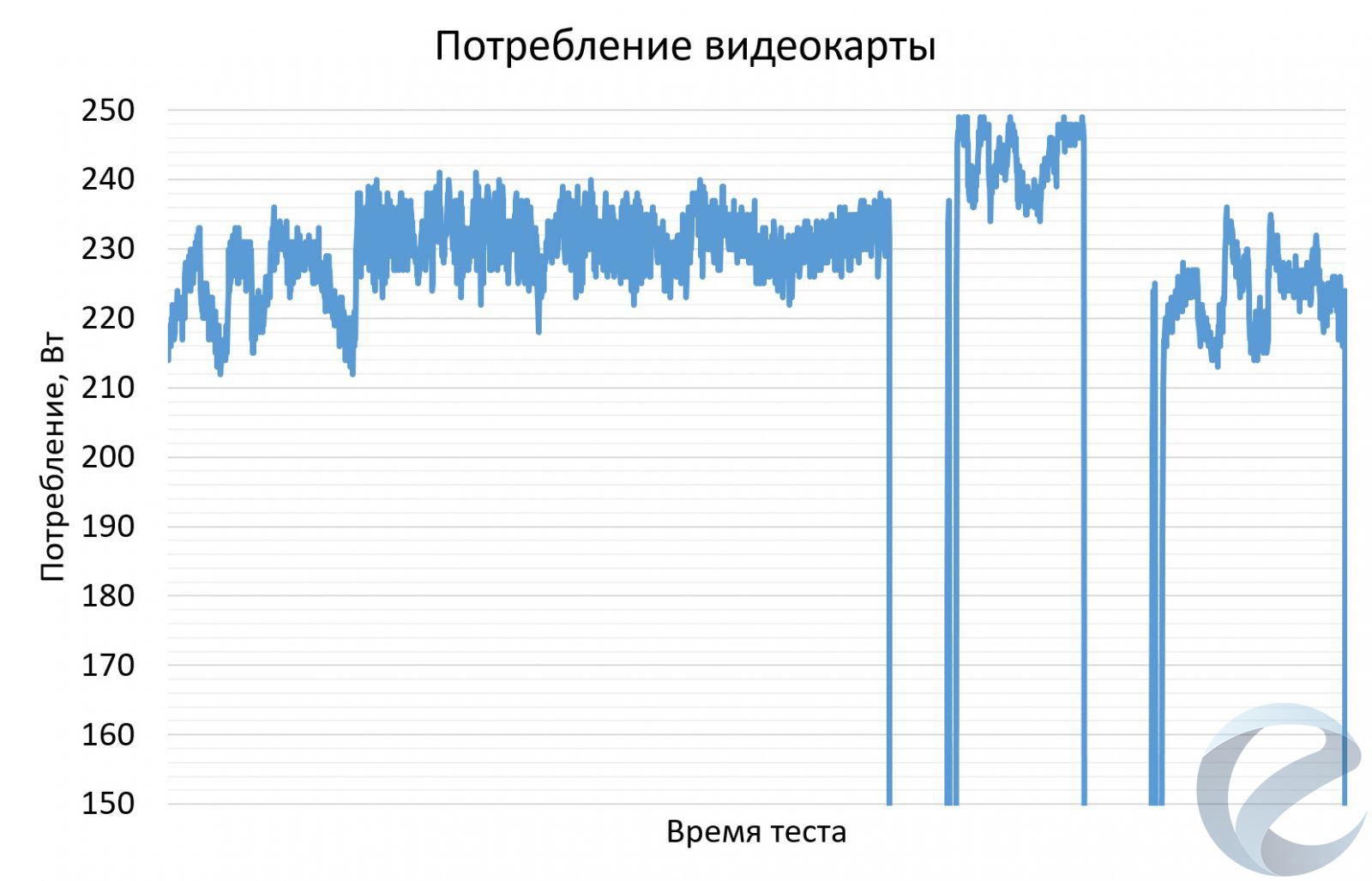

Температура графического процессора не превысила 75оС, память прогрелась немногим больше - до 77оС. Система охлаждения справлялась на удивление отлично - изначально обороты поднимались немного выше среднего значения, затем устанавливались на 2100 оборотах в минуту. 165-180 Вт система охлаждения отводит и тихо, и продуктивно.

Следующим этапом была имитация максимальной игровой нагрузки. Для этого использовался тест Firestrike Ultra с ручной настройкой, чтобы оставить только графические тесты - Demo, GT1 и GT2.

И здесь ситуация несколько изменилась - в первом графическом тесте (GT1) частота графического процессора опускалась до 1270 МГц из-за нехватки лимита потребления. Как видно по графику, потребление графического процессора находилось на уровне 170 Вт.

Скачки напряжения достигали 1.15 В, но большую часть времени не превышало 1.02 В. Из-за небольшой продолжительности теста температура графического процессора едва перевалила за 70оС, но по графику становится понятно, что основной упор был в производительность системы охлаждения - теплоотдача с кристалла осуществляется отлично.

Температура памяти HBM2 поднималась немногим выше, чем у графического процессора. Но разница не превышает и 5оС. Это происходит из-за того, что графический процессор и память располагаются на одной подложке. Вращение вентилятора системы охлаждения при этом не превышало 2400 оборотов в минуту.

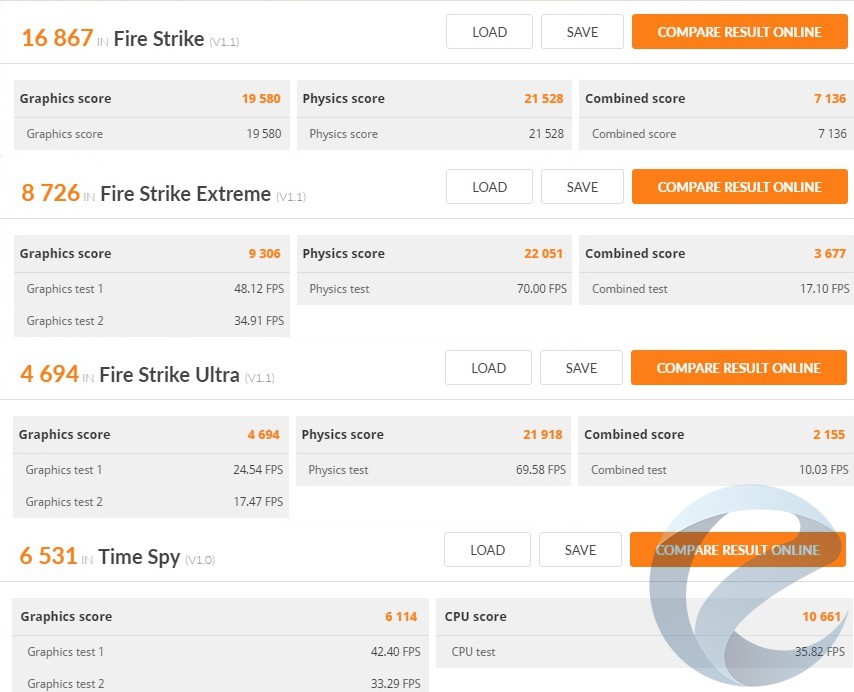

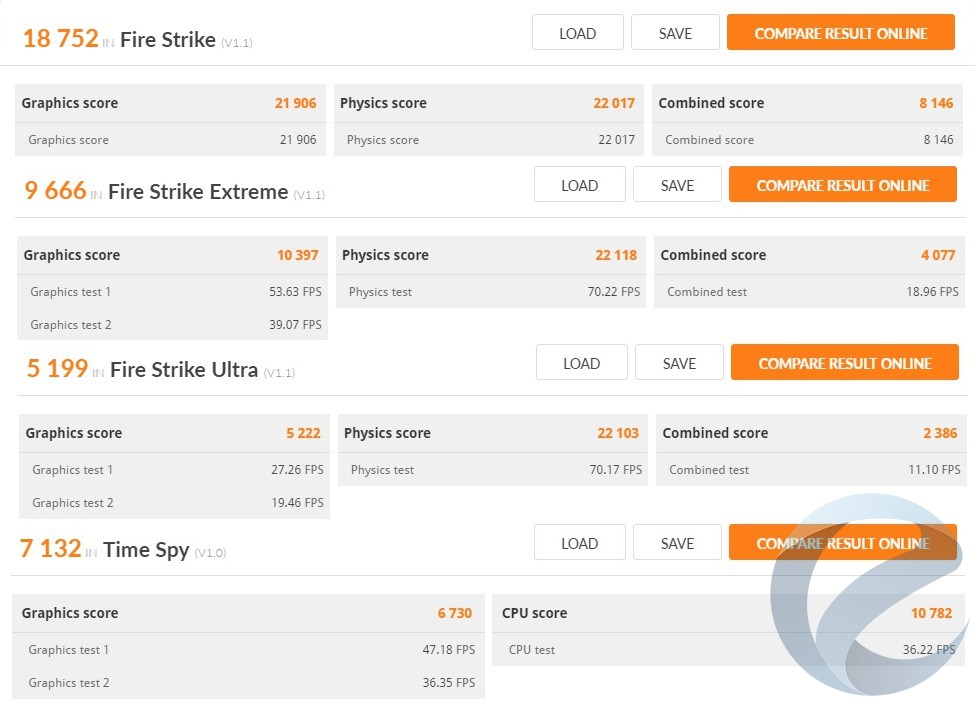

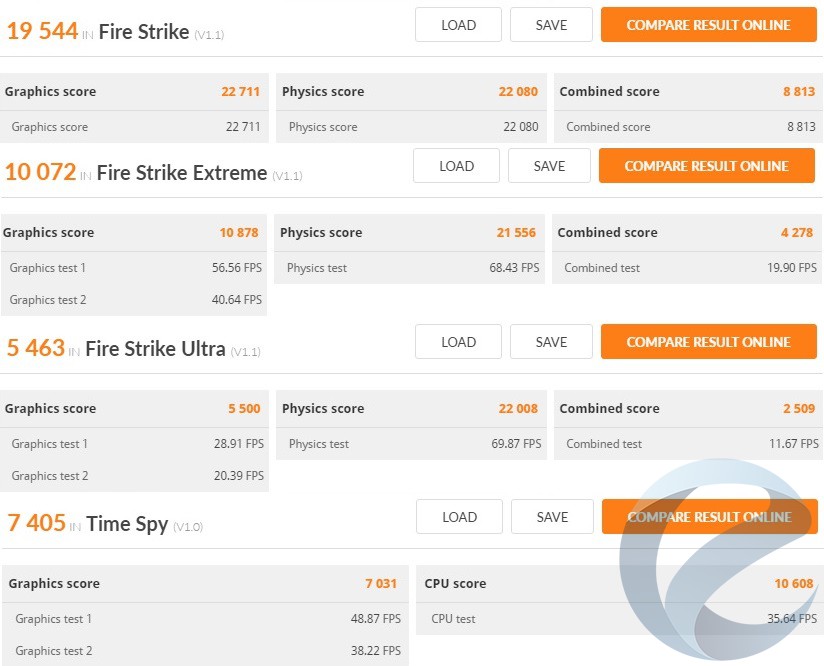

На заводских установках в комплексе приложений 3DMark видеокарта показала следующие результаты:

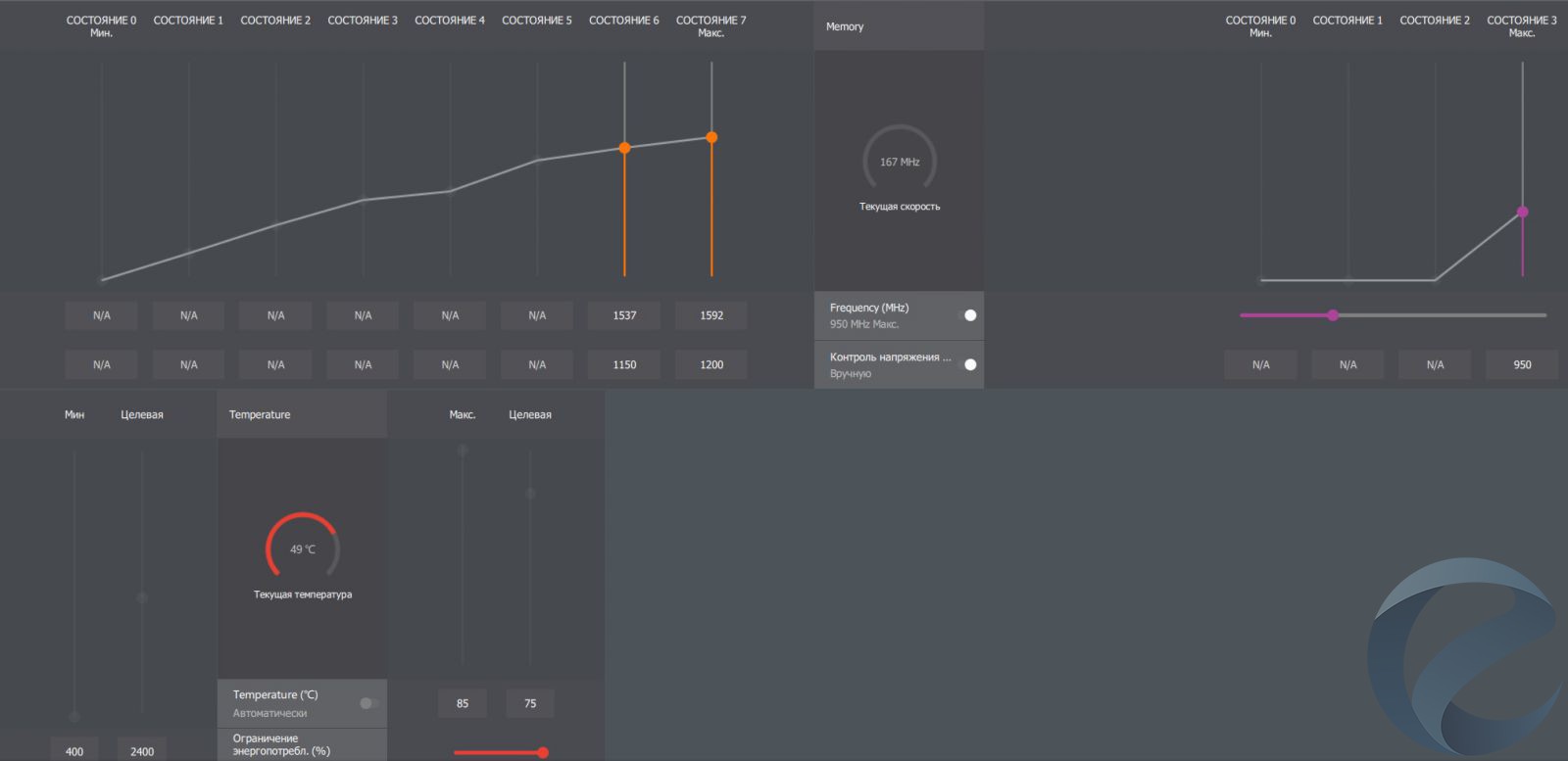

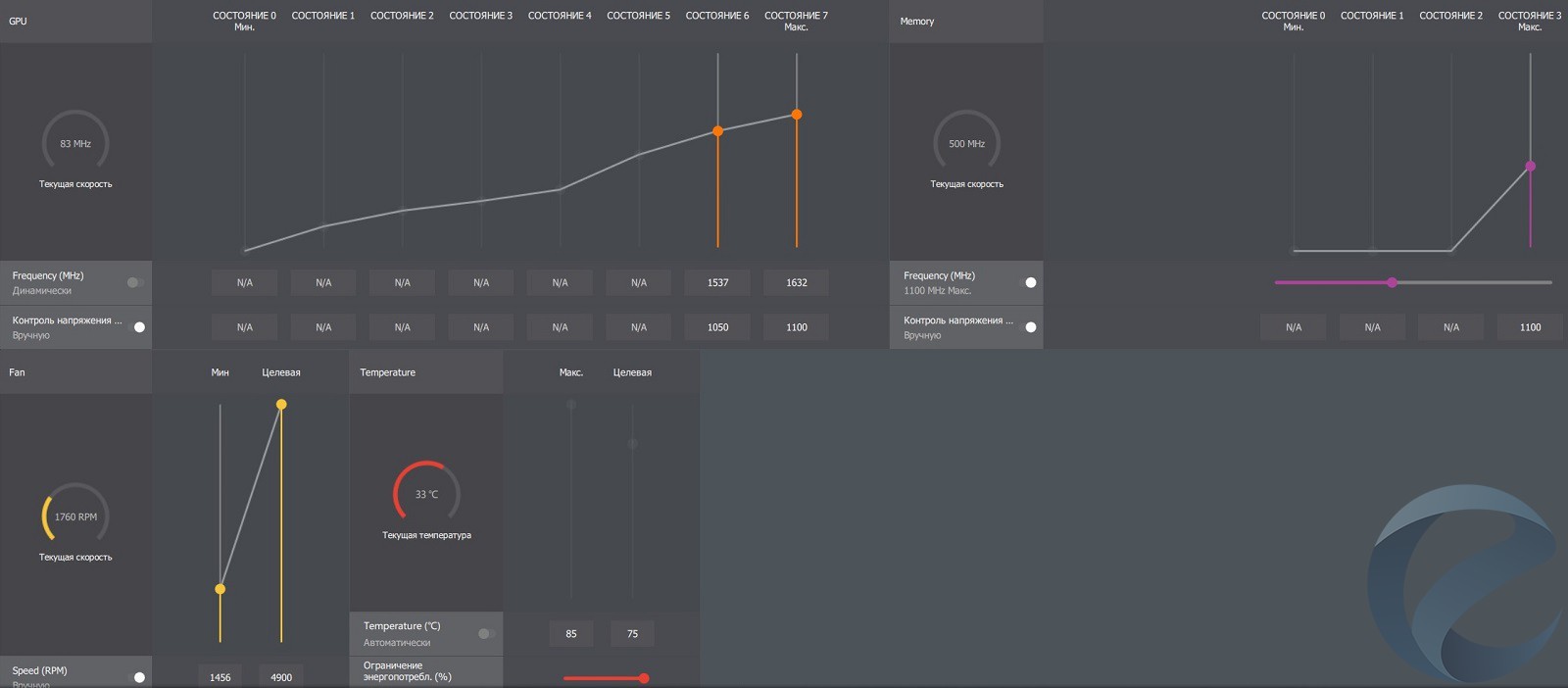

С помощью Wattman, встроенного в панель управления RadeonSoftware Crimson, мы занялись примитивным разгоном - увеличение частоты памяти и лимита мощности до предела. Единственное - увеличение частоты ядра ничего не давало, т.к. всё упиралось в ограничение по потреблению.

Прирост производительности впечатляет, однако становится понятно, что напряжение - явно избыточное для таких частот

Для этого мы снижаем рабочее напряжение для состояний P6 и P7:

Частоту памяти для нашего экземпляра при этом пришлось снизить на 10 МГц относительно прежнего эксперимента, и она достигала 940 МГц (1880 МГц эффективная).

Повторение тестирования в графических приложениях Firestrike Ultra показало улучшение частотных показателей нашего экземпляра - частота держалась выше 1520 МГц на всём протяжении теста. С ручной настройкой оборотов вентилятора температура не превысила 70оС.

Напряжение графического процессора в среднем находилось на отметке 1 В, и, несмотря на столь небольшое значение, пиковое потребление достигало 250 Вт.

Температура HBM2 памяти немногим превысила 70оС, а вот с оборотами вентилятора при ручной регулировке возникли непонятки - если во время Demo обороты не достигали 3000, то в двух последующих тестах, даже при более низкой температуре, обороты поднимались до 3500 и шум становился сильным.

А вот производительность на такой настройке не может не впечатлить - результаты оказались выше, чем при обычном разгоне.

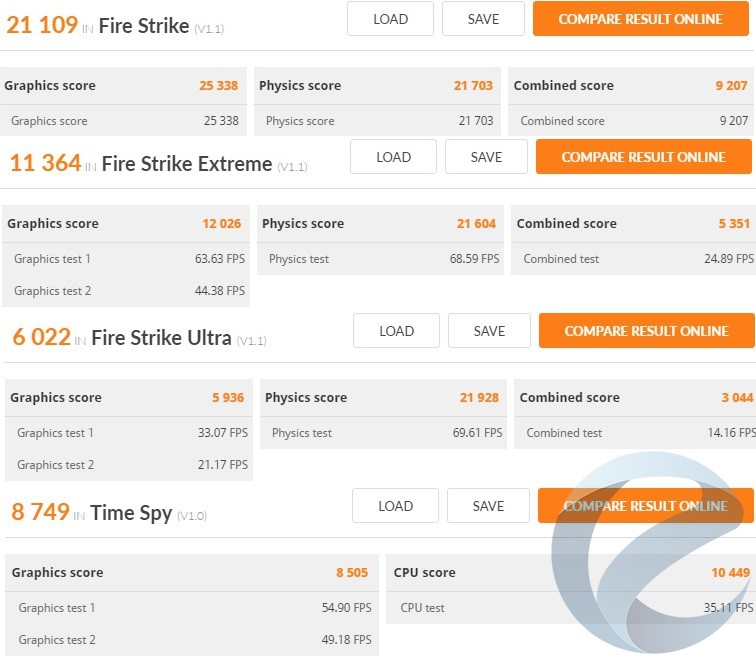

Для сравнения производительности мы использовалиMSI GeForce GTX 1080 GAMING X+ 8G.

Нереференсная версияGeForce GTX 1080была разогнана до 2100 МГц по графическому ядру, а частота памяти была повышена с 11000 МГц до 12000 МГц.

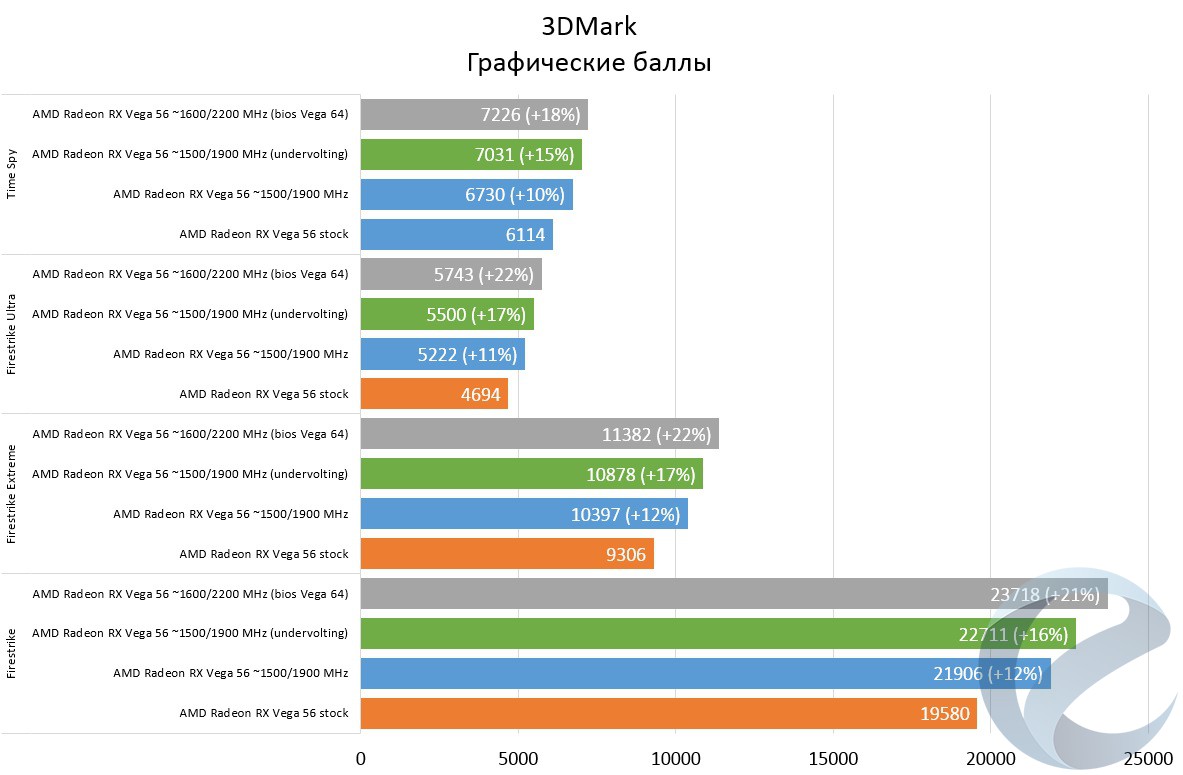

Результаты в 3DMark оказались достаточно высокими относительно показателей референсной модели:

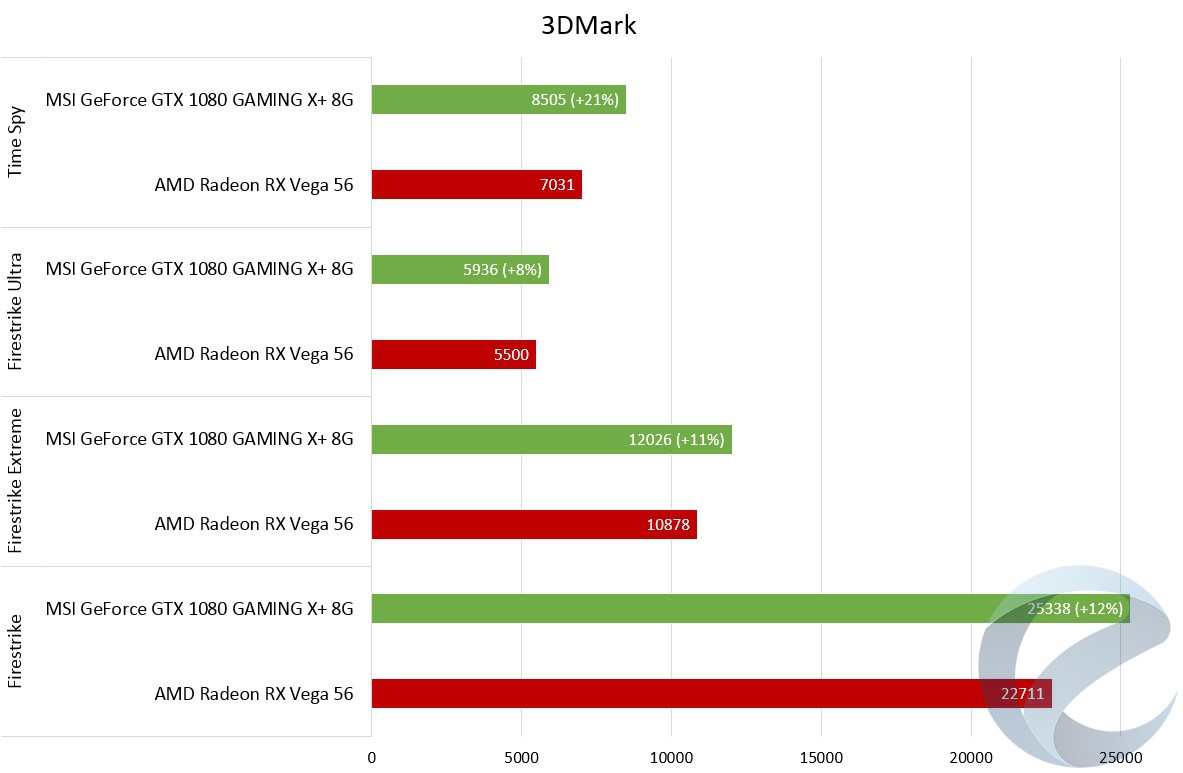

Если сравнить результаты разогнаннойMSI GeForce GTX 1080 GAMING X+ 8G с андервольтингом наAMD Radeon RX Vega 56, то результаты получаются несколько прозаичными:

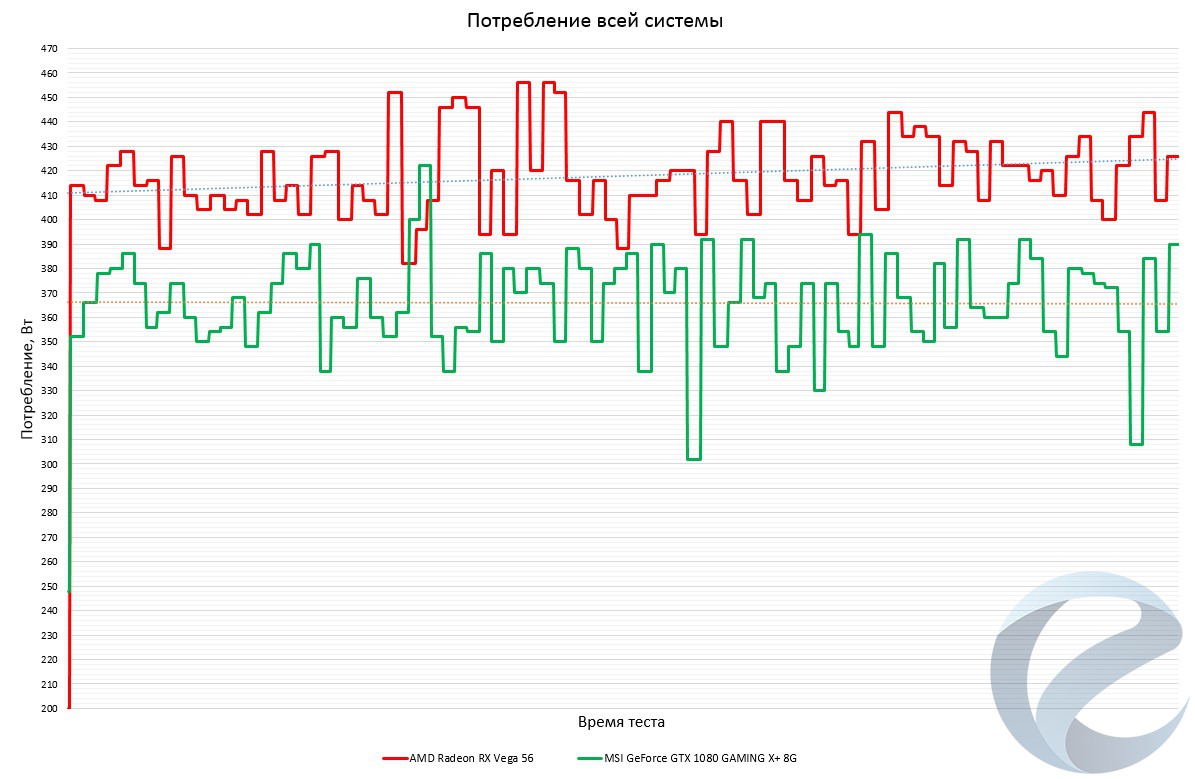

Самый большой отрыв от героини нашего обзораGeForce GTX 1080получает в тесте Time Spy - видеокарта NVIDIA оказалась впереди на 21%. А вот в тестах Firestrike преимущество уже выражено слабее - от 8 до 12%. И здесь наступает ключевой вопрос - потребление видеокарт. Для этого в Firestrike Ultra Demo мы замерили потребление с выхода блока питания всей системы.

Средняя разница в потреблении находится на уровне 45-50 Вт. Учитывая, что при том же потреблении некоторые экземплярыAMD Radeon RX Vega 56могут работать и на частоте около 1600 МГц - вполне себе достойный результат, явно не то, что мы ожидали после многочисленных обзоров.

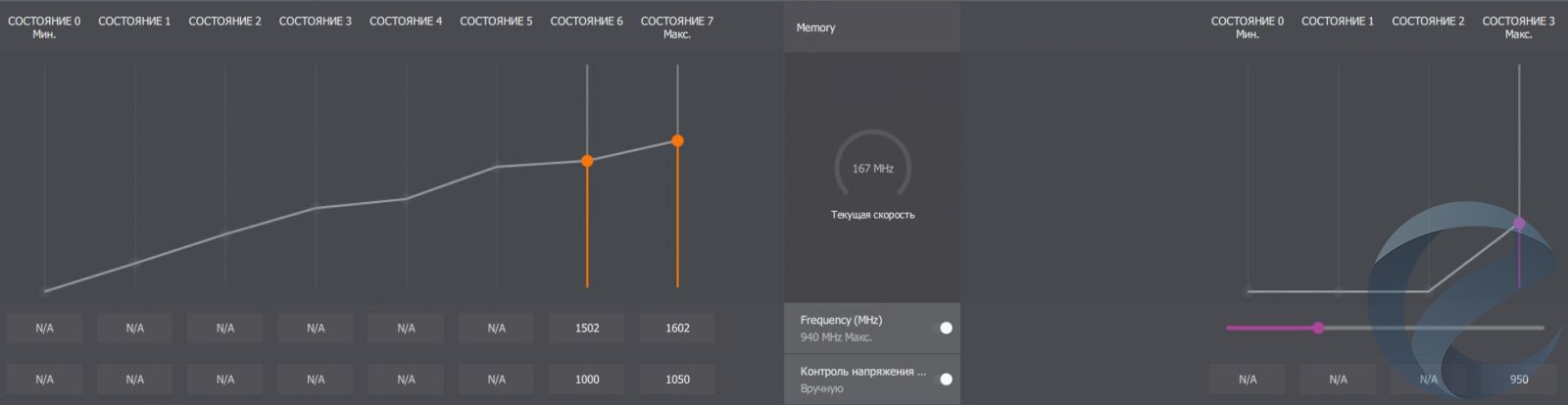

Прошивка BIOS отAMD Radeon RX Vega 64

Не так давно программаTechPowerUp GPU-Z показала первым энтузиастам, прошившим BIOS от старшей модели вAMD Radeon RX Vega 56в надежде разблокировки отключенных ядер, лучик надежды:

Однако, как оказалось на самом деле, это была обычная ошибка в самой программе и никакие утраченные блоки не появлялись. Но, тем не менее, сама прошивка приносит свои плоды - во-первых, расширяются максимальные лимиты потребления, во-вторых, увеличивается напряжение на память HBM2, что благоприятно влияет на разгон. Базовые частоты также меняются.

Мы решили не упускать шанс и проверить пользу от разблокировки собственноручно.

Сам процесс очень прост - скачиваем нужную версию BIOS (RX Vega 64 AIR,RX Vega 64 AIO) , и с помощью ATIWinflashv2.77 (более старые версии AMD Radeon RX Vega не поддерживают) прошиваем его вAMD Radeon RX Vega 56.

После успешной прошивки с помощьюDisplay Driver Uninstaller (DDU)перезагружаемся в безопасный режим и удаляем драйверRadeon Software Crimson ReLive Edition. Перезагружаемся и устанавливаем последнюю версию видеодрайвера. Поздравляем, перед нами немного обрезаннаяAMD Radeon RX Vega 64.

Стоит отметить, что без особых ухищрений наш экземпляр видеокарты работал на частоте ~1600 МГц по ядру, а частота HBM2 была увеличена до максимальных 1100 МГц (к слову, в следующем обзоре мы обойдем данное ограничение).

Играючи карта показала себя во всей красе, при этом энергопотребление выросло незначительно, так как мы не использовали весь потенциал напряжения.

Зависимость производительности от разгона и версии BIOS отображена на следующем графике:

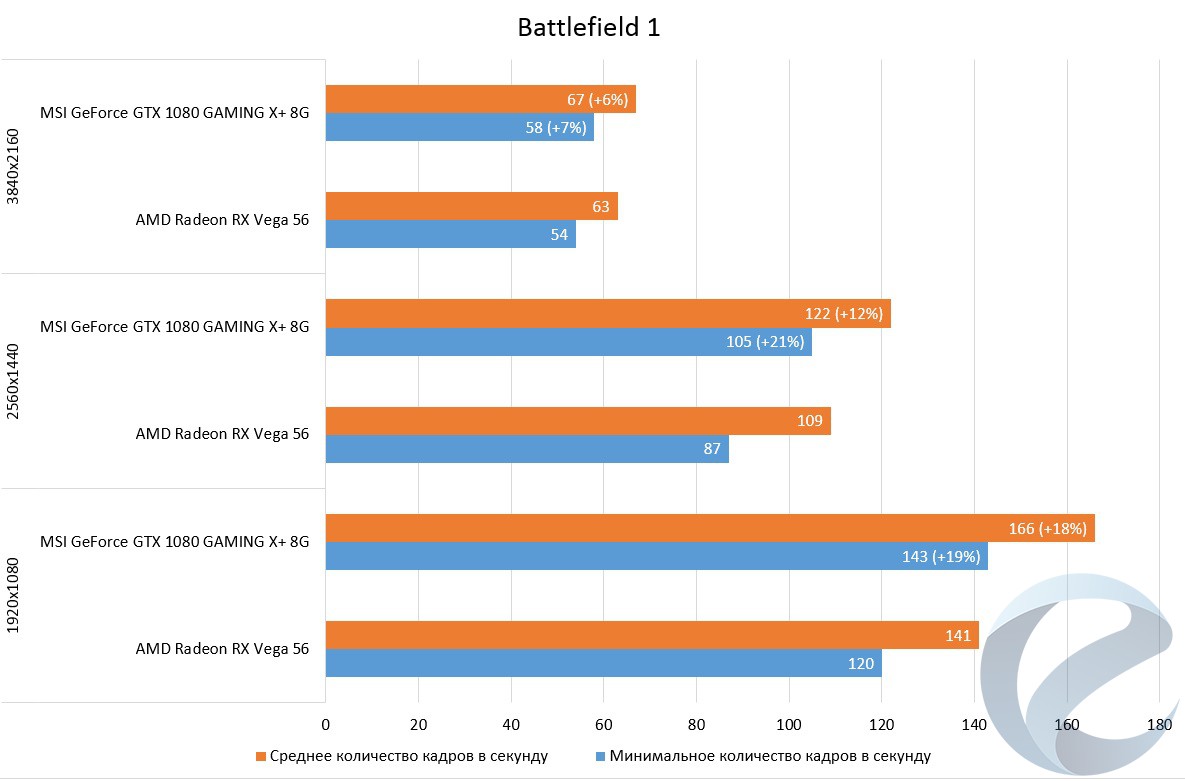

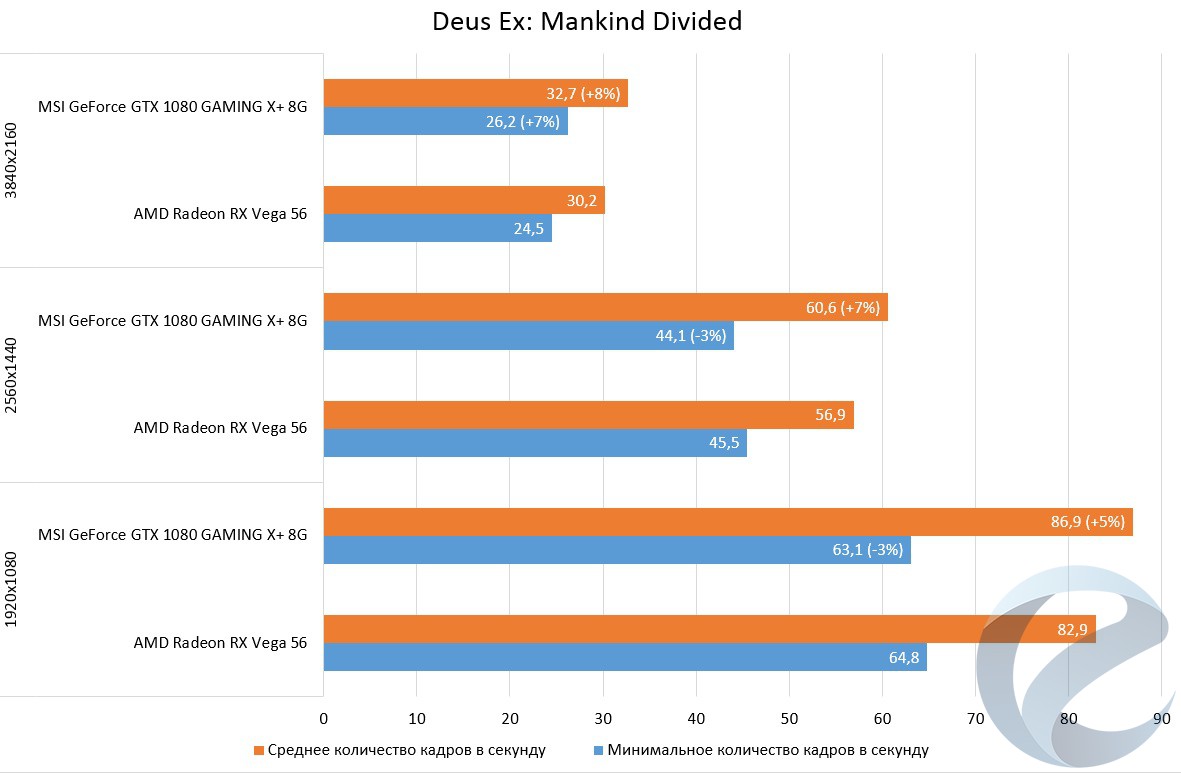

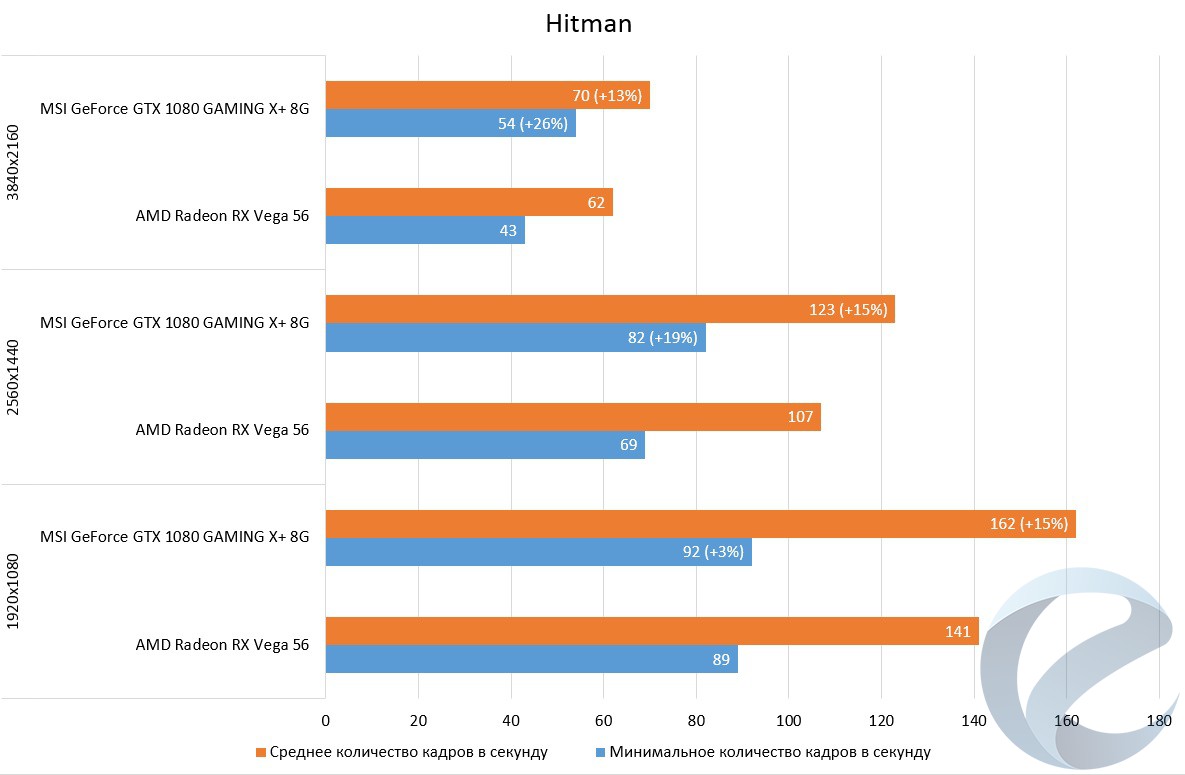

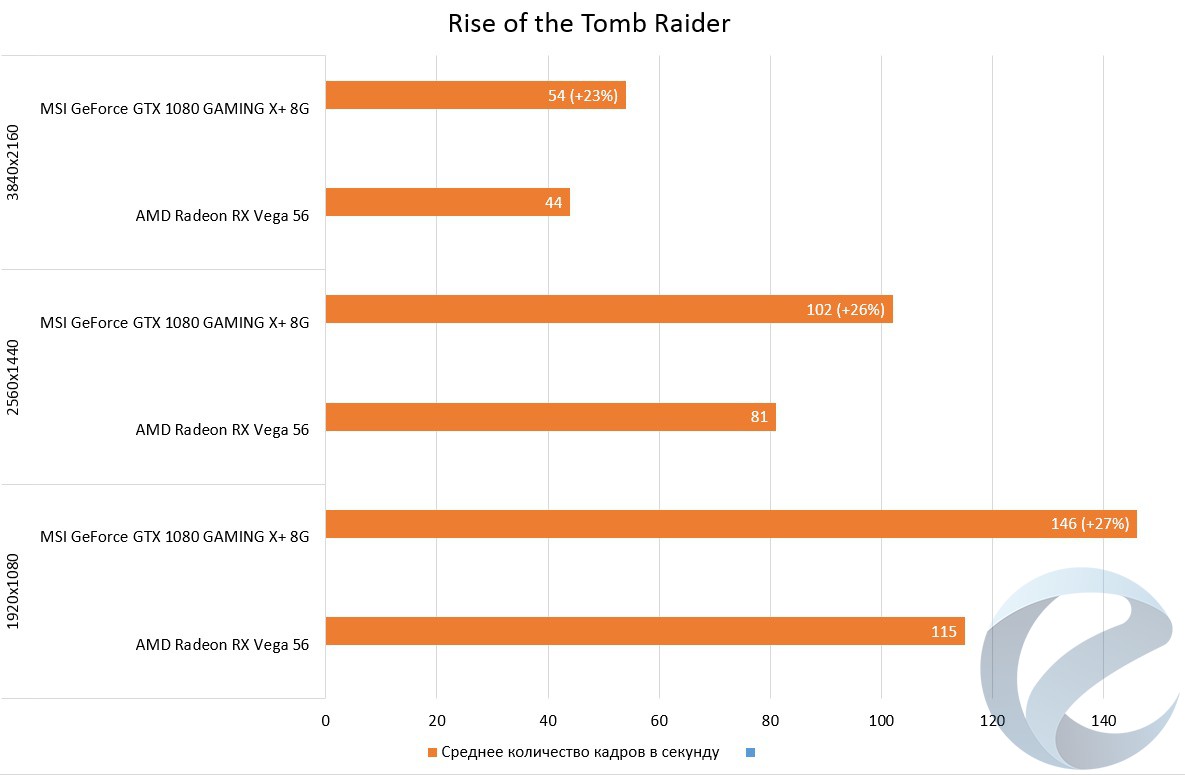

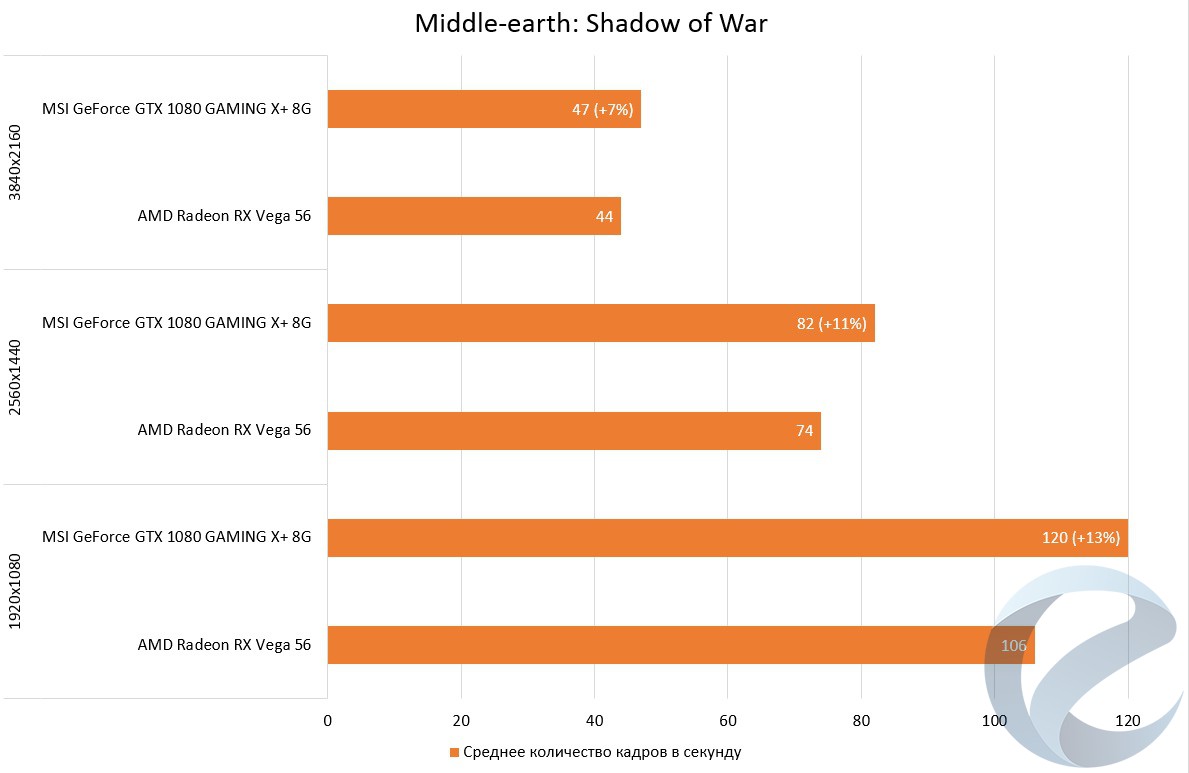

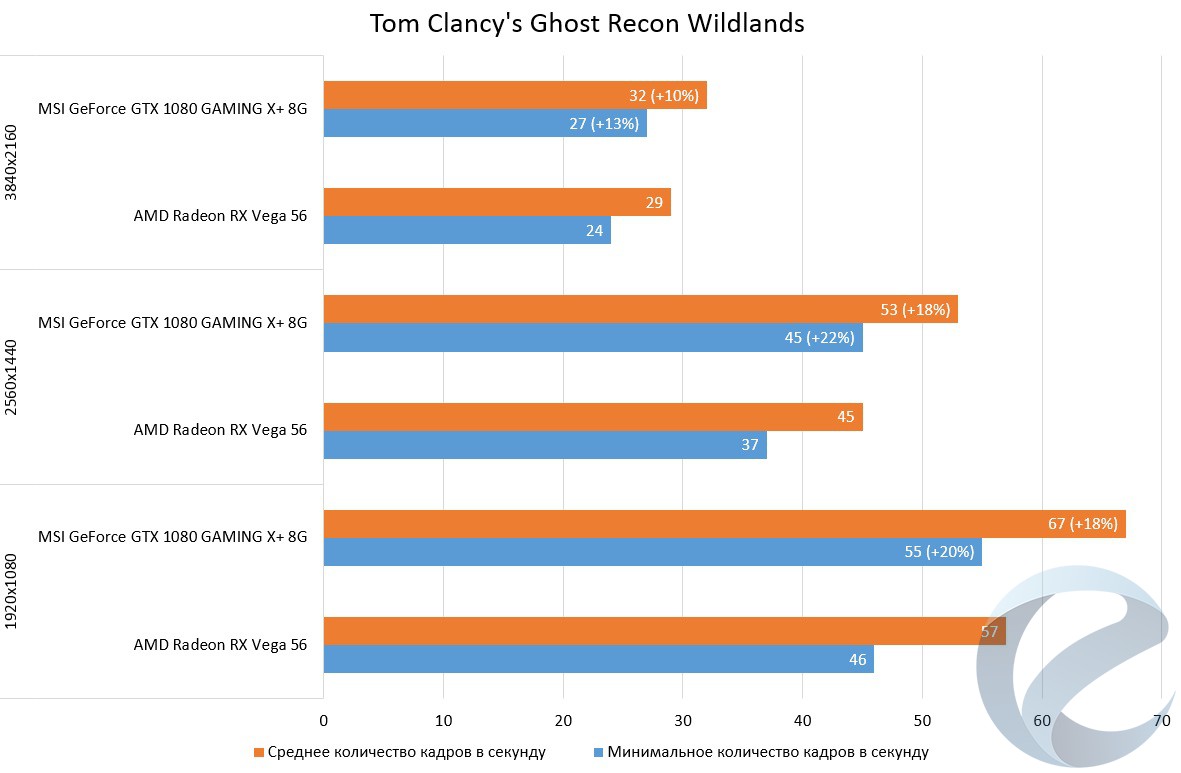

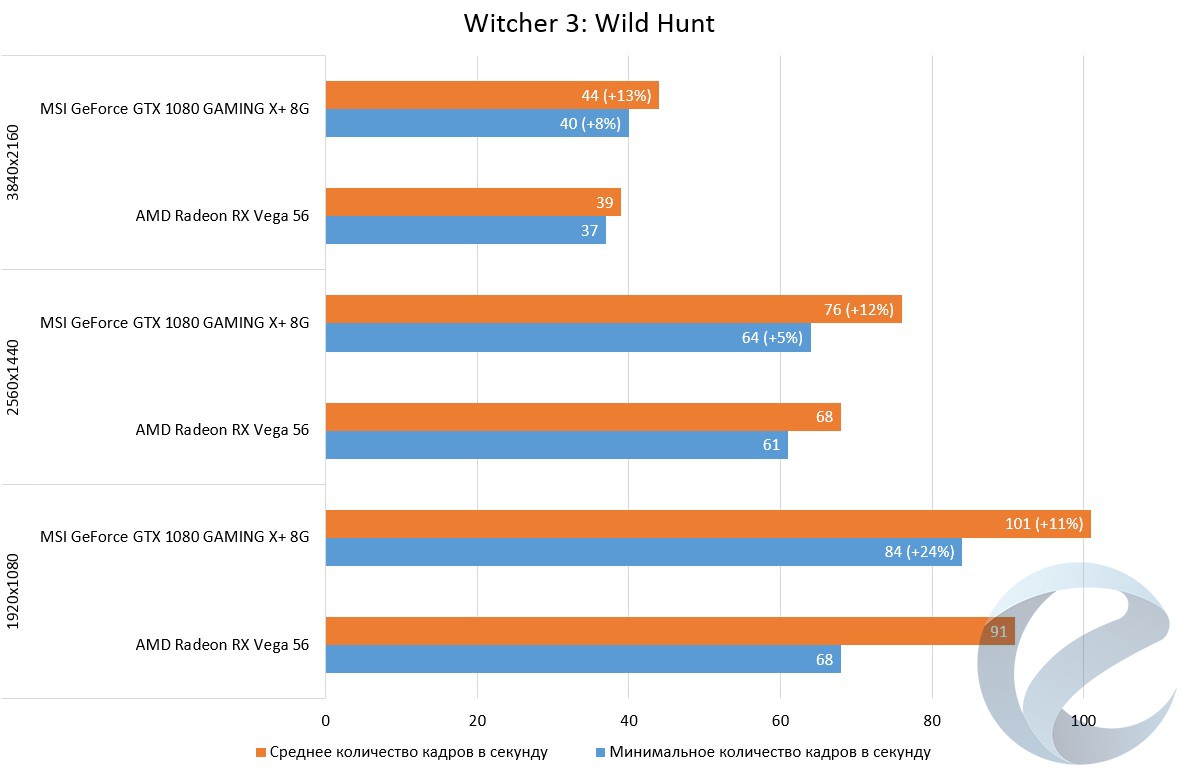

Игровая производительность

Тестирование игровой производительности происходило в семи играх. ДляBattlefield 1 иThe Witcher 3: Wild Hunt использовались следующие внутриигровые отрезки:

Фиксирование показаний среднего и минимального количества кадров в секунду происходило с помощью программы Fraps.

В остальных играх тестирование проводилось во встроенных бенчмарках.

Настройки устанавливались максимальные, кроме сглаживания. Тестирование проходило в трех популярных игровых разрешениях - 1920х1080 (FHD), 2560x1440 (QHD), 3840x2160 (UHD).

Тестирование проводилось на разогнаннойMSI GeForce GTX 1080 GAMING X+ 8G и AMD Radeon RX Vega 56 с андервольтингом (параметры, на которых проходило сравнение в 3DMark).

Результаты отображены на следующих графиках.

Что здесь можно сказать - "кто девушку ужинает, тот её и танцует". В зависимости от игры и внедренных в нее технологий мы видим то отставаниеAMD Radeon RX Vega 56от максимально разогнаннойMSI GeForce GTX 1080 GAMING X+в 5-7% (Deus Ex: Mankind Divided), то огромный разрыв в 23-27% (Rise of the Tomb Raider). В среднем же можно говорить о 10-15% превосходства разогнанного нереференсаMSI GeForce GTX 1080 GAMING X+над референсомAMD Radeon RX Vega 56. Думаем, что комментарии излишни.

Хотелось бы еще поговорить о HBCC. Данная технология позволяет расширить доступное адресное пространство памятиAMD Radeon RX Vega 56за счет использования оперативной памяти. Однако, говорить точно о преимуществе данной технологии мы не готовы - на примере игрыMiddle-earth: Shadow of War с установленным паком текстур высокого разрешения и установленном разрешении 4К можно сказать одно - технология работает, все мониторинги видят адресное расширенное адресное пространство видеокарты... Но на показателях framerate и frametime это не сказывается. Поэтому данный вопрос, как иCrossFire, который наAMD Radeon RX Vegaна данный момент не работает в некоторых играх (гдепри этомон работает на пареRadeon RX580),мы откладываем до следующего обзора, тем более, что простора для материала много, а осень всегда богата на игровые новинки.

Заключение

Что можно сказать о видеокартеAMD Radeon RX Vega 56? Если вспомнить, что мы тестировали референсную модель, то можно пожаловаться на несколько горячий нрав, на ограничение лимита потребления, на шум одного вентилятора при разгоне. Однако, если рассматривать с технической точки зрения, то видеокарта обладает отличным графическим процессом, неплохой системой охлаждения (для андервольтинга в самый раз)и ужасной реализацией BIOS - вентиляторы в простое практически не крутятся, граничная температура отодвинута до 75оС, а обороты ограничены 2400,зашитые напряжения оказываются избыточными. После ручной доработки видеокарта может неплохо выстрелить и наступать на пятки разогнанному нереференсуGeForce GTX 1080с обновленной памятью (11 Gbps). Да, потребление при этом оказывается немногим выше, но для видеокарты это не предел производительности, и основными ограничениями тут будут температуры памяти и графического процессора. Получается, что мы имеем производительность междуGeForce GTX 1070иGeForce GTX 1080. На данный момент конкурент готовит к массовому выпускуGeForce GTX 1070 Ti,которая как раз прикроет эту брешь. И, несомненно, на этот шаг NVIDIA пошла не просто так - значит она видит в этом сегменте конкуренцию. Остается лишь вопрос цены - мониторы с Freesync стоят дешевле аналогов, а у AMD, судя по всему, есть еще подушка в ценовой политике.

А нами вопрос производительностиAMD Radeon RX Vega 56еще не закрыт - далее нас ждет установка водоблоков полного покрытия и проверка видеокарт вCrossFire.

.jpg)