Обзор и тест GUNNIR Photon ARC A380. Сравнение с Radeon RX 6400 и GeForce GTX 1066

Уже почти год прошёл с тех пор, как мы познакомились с первой дискретной видеокартой нового поколения от intel. Только по сути своей она являлась мобильной графикой, подключаемой через PCI Express. Этот прототип был необходим для оптимизации софта разработчиками, написания драйверов и создания прочих улучшений для будущих полноценных видеокарт. И вот, спустя год, давайте посмотрим, на что способна младшая представительница новой линейки intel с кодовым названием alchemist, ARC A380.

Всего было показано 2 чипа на всё семейство, и наша новинка содержит в себе тот, что поменьше. Старший же чип содержит в 4 раза больше различных юнитов и ядер.

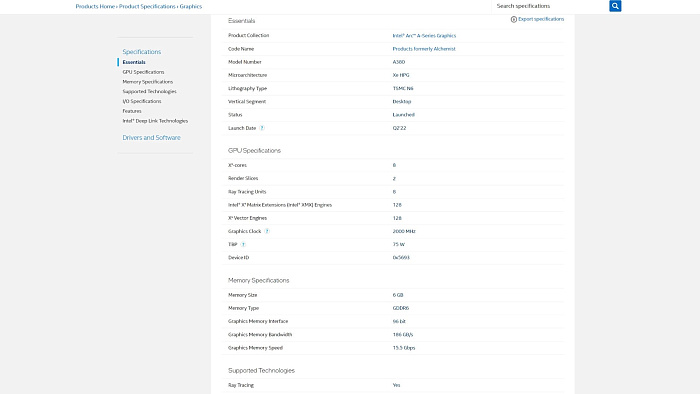

Сами характеристики видеокарты мало говорят о производительности, но по ним можно понять, что в А380 6 Гб видеопамяти типа GDDR6. Хотелось бы 8, но спасибо, что не 4. Однако PCI Express 4.0 ограничен 8-ю линиями. В дополнение ко всему наблюдается наличие RT ядер.

Видеокарта нацелена на китайский рынок, поэтому вы могли не слышать о бренде GUNNIR, в чьём исполнении она создана. К тому же недавно своё творение анонсировали ASRock и оно вот-вот появятся в продаже. Внешне видеокарта не привносит новшеств. Самая обычная система охлаждения из простого радиатора с одной теплотрубкой, обдуваемого двумя 90 мм вентиляторами.

Питание тоже стандартное 8-пин, видеовыходы обычные: 3 DisplayPort и 1 HDMI.

Первое включение

В отличие от DG1, к которой нужен особый подход, A380 запустилась с первого раза. Разрешение экрана ожидаемо было минимальным и спустя минуту не вернулось в норму, значит автоматически драйверы не установились. Заранее скачанный драйвер запустился тоже не с первого раза, заставил понервничать, но вскоре заработал. В меню установки помимо драйвера есть возможность установить фирменную утилиту intel Arc Control, но она строго привязана к Driver Support Assistant, что показалось странным. По окончанию установщик самостоятельно закрылся, не сообщая об успешной установке драйвера. После чего Driver Support Assistant, который нас заставили установить, ещё в течение минуты прилично грузил наш 5800X3D, а по окончанию своих поисков сообщил о трёх обнаруженных обновлениях. Только вот незадача - посмотреть на них можно только в браузере, но в России без VPN сайт не работает.

Не больно и хотелось. Давайте лучше познакомимся с новой утилитой Intel Arc Control. Но вот только хоть мы её и установили, запускаться она не будет. Нужно установить её ещё один раз с помощью того самого Driver Support Assistant.

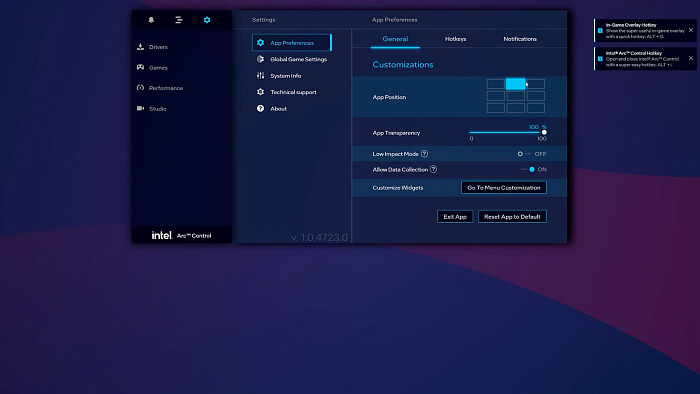

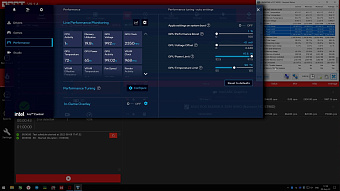

Хорошо, после второй установки всё заработало, смотрим. Запустить оверлей можно сочетанием клавиш Alt+I. Здесь достаточно много привычных нам возможностей, которые давно есть в софте конкурентов, поэтому покажем, за что глаз зацепился. Например, в настройках приложения можно задать ему одну из 9 позиций и прозрачность, но курсором передвинуть нельзя.

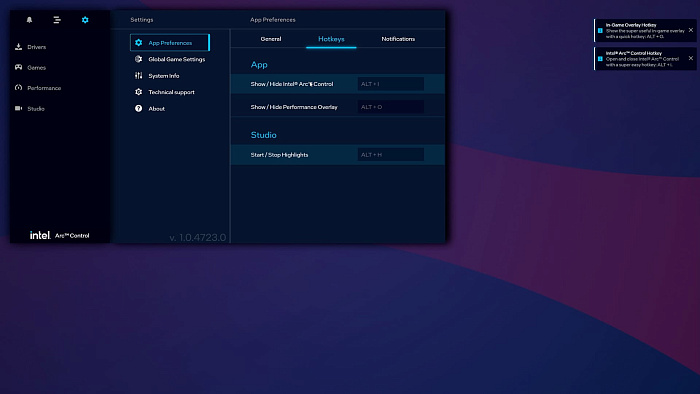

Меню горячих клавиш содержит только 3 сочетания, которые ещё и изменить нельзя. То есть мы не можем включить запись экрана или сделать скриншот.

В глобальных настройках для игр помимо автоматического подбора графического пресета можно включить шарпинг, однако в играх его не видно, зато в браузере и лончерах он вызывает артефакты.

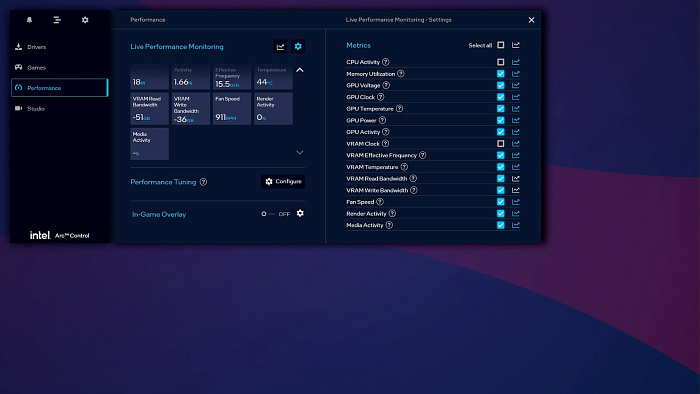

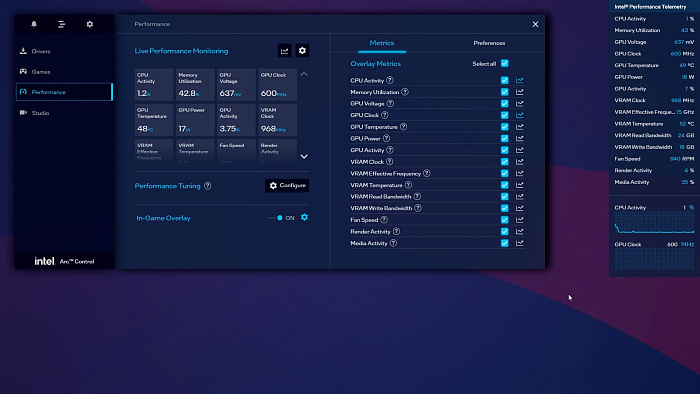

Во вкладке “производительность” доступен настраиваемый мониторинг. Здесь можно выбрать как отслеживаемые датчики, так и отдельно добавить их в список графиков.

Подменю Performance Tuning отвечает за разгон видеокарты - это мы оставим на десерт.

In-Game Overlay содержит тот же мониторинг, но в виде небольшого оверлея. Как вы могли заметить, на момент записи футажа он уже успел сломаться. А это ещё второй день использования видеокарты. Правда через несколько дней после многократной замены видеокарт он снова заработал. Список датчиков здесь тот же, но графиков больше двух не вывести, а график частоты видеоядра сломан. Также здесь отсутствует мониторинг FPS, что является важным упущением.

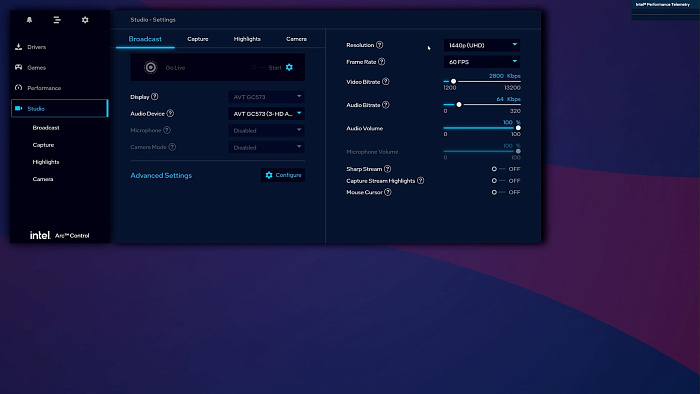

Вкладка Studio тоже неприятно удивила. Максимальное разрешение стрима выше 1440p не установить, причём intel по какой-то причине называет это Ultra HD, а не Quad HD. Битрейт при этом выше 13200 Кбит/сек не установить, это критично для ютуба, да и непонятно, откуда такое ограничение. Причём сейчас, пока пишется сценарий, выбрать Quad HD разрешения уже нельзя. Оно исчезло. Драйвер не менялся.

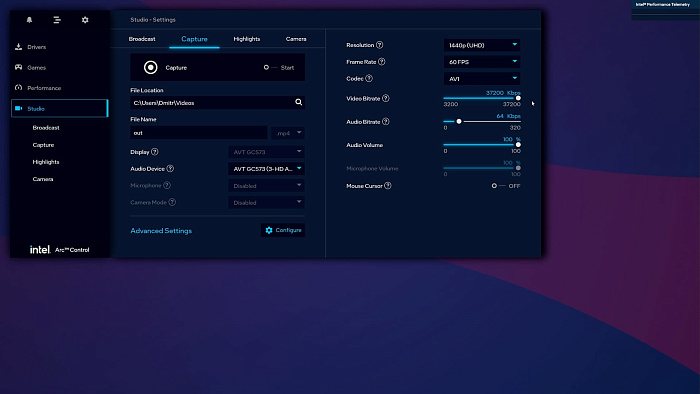

С записью те же непонятки. Перед вами на футаже максимум 37 Мбит/сек, но позже оно превратилось в 13 Мбит/сек. Да, можно писать с помощью кодека AV1, но без горячей клавиши делать это попросту неудобно. Ещё он то не хочет запускать запись, то останавливать.

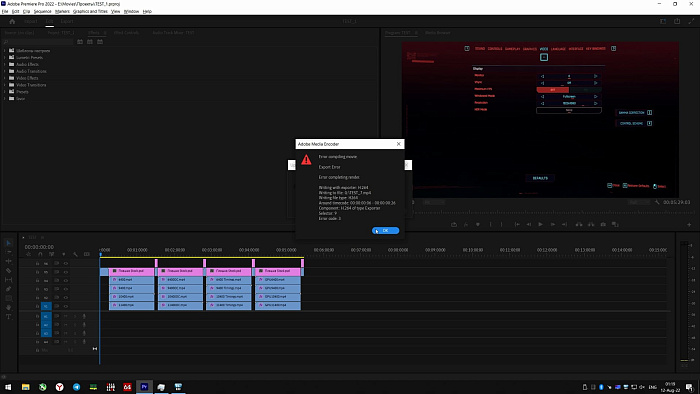

Причём, когда у нас дошли руки до тестовых записей, Arc Control уже демонстрировал максимальный битрейт в 63 Мбит/сек как для стрима, так и для записи экрана. Однако стоило попытаться постримить, как выяснилось, что в 1440p этого делать нельзя, максимум Full HD 60 FPS. Но это ещё не всё. После запуска стрима отобразилось соответствующее уведомление, однако на ютуб поток не приходил. Как выяснилось, в тот день кодировщик нашей видеокарты взял выходной. Это не шутка. В монтажных программах возникали ошибки при попытки рендера, а запись экрана создавала пустые неоткрываемые файлы. Но, как и с оверлеем, это само починилось через несколько дней.

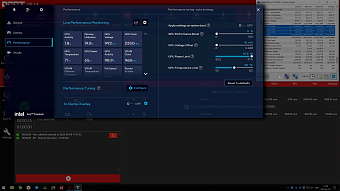

Время десерта: разгон.

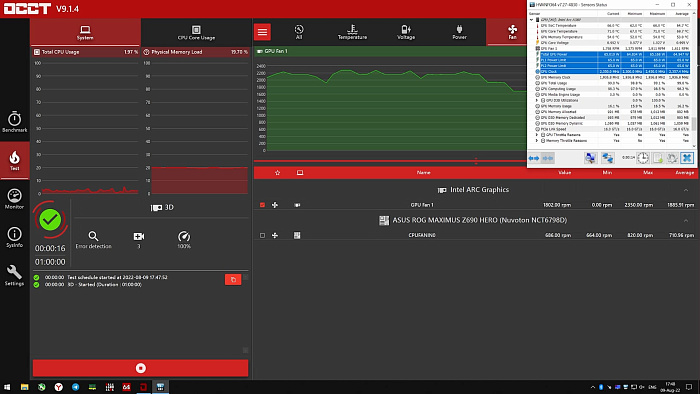

Для начала запускаем стресс-тест видеокарты и смотрим на показатели. HWiNFO 64 сообщает, что максимальная частота видеокарты достигала 2450 МГц, но из-за лимита мощности в 65 Вт снизилась до 2350 МГц.

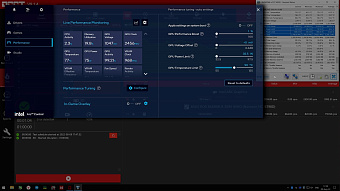

Простейшая возможность это исправить - повысить лимит мощности. Нам разрешено поднять его до 97.5 Вт.

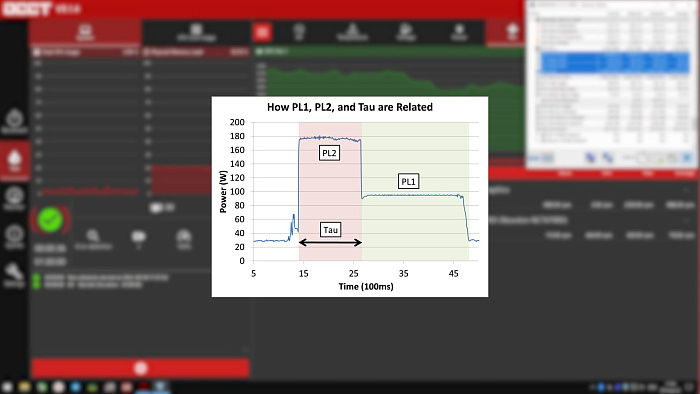

HWiNFO сразу среагировал на изменение, датчик PL1 увеличился до заданного значения, но если проводить аналогию с процессорами intel, то выходит, что у нас PL1, то бишь долгосрочный лимит, выше, чем краткосрочный. Причём сколько бы времени не проходило, видеокарта упирается во временный лимит. Если бы HWiNFO просто перепутал их местами и на самом деле мы изменили PL2, то по прежней аналогии у нас было бы временное повышение лимита до этих 97 Вт, а после снижение до 65 Вт, но даже после отдыха в первые секунды стресс-теста упор был по-прежнему в 65 Вт.

То бишь эта настройка сама по себе ничего не даёт. Однако, если минимально увеличить GPU Performance Boost или оффсет напряжения, то PL2 подскакивает до 800 Вт и видеокарта начинает потреблять больше.

При этом, если уменьшить лимит до 37 Вт, то видеокарта будет потреблять 55 Вт, что очень “логично”

А если лимит не трогать и увеличить только PL2 через минимальный разгон, то у нас снова будет упор в лимит 65 Вт.

То есть менять нужно и то, и другое. При этом даже так видеокарта не будет свободна. Её потребление скачет между 77 Вт и 65 Вт.

Что касаемо самого разгона, тут тоже всё непредсказуемо. В нашем случае увеличение ползунка до отметки в 10% увеличивает частоту на 50 МГц, то бишь на 2%. А дальнейшее его передвижение приводит к падению частоты ниже стокового буста.

Если GPU Performance Boost не трогать и едва увеличить оффсет напряжения, то частота внезапно увеличивается уже на 100 МГц от стока и дальнейшее увеличения оффсета ничего не даёт.

Причём, как выяснилось позже, разгон через GPU Performance Boost, несмотря на более низкий прирост в частоте, даёт больший прирост производительности, чем через оффсет. В то же время сочетание этих разгонов даёт уменьшение производительности, а изменение частоты видеопамяти или её таймингов недоступно.

Хорошее начало, не правда ли?

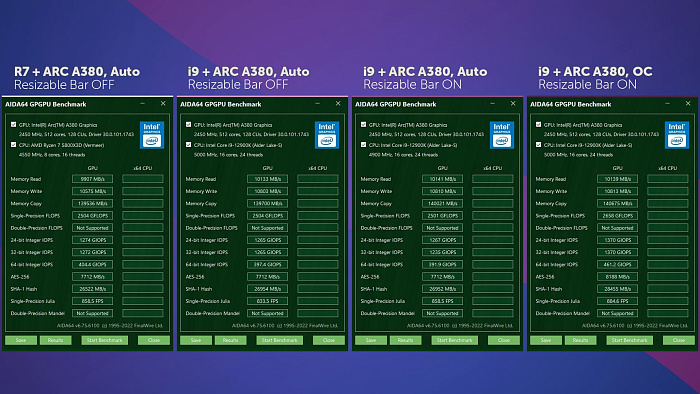

Теперь давайте закроем вопрос о производительности на платформе intel, AMD, приросте от Resizable Bar и разгоне. От AMD у нас 5800X3D, а от intel 12900K. Остальной тестовый стенд осветим позже.

GPGPU Benchmark в Aida64 сообщает, что с AMD пропускная способность памяти, зависящая от скорости PCI Express, на 200 МБ/сек ниже, в остальном разницы мало. ReBar ничего не дал, а разгон, наоборот, увеличил некоторые показатели абсурдно сильно. Если по ГФлопсам мы имеем 6% прирост при 2% увеличении частоты, то 64 Битные операции стали обрабатываться более чем на 15% быстрее.

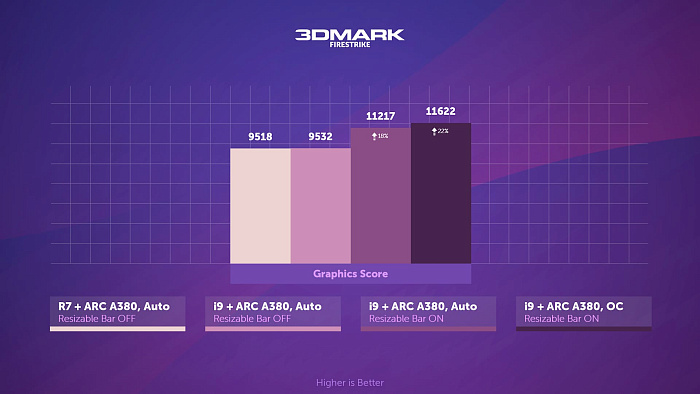

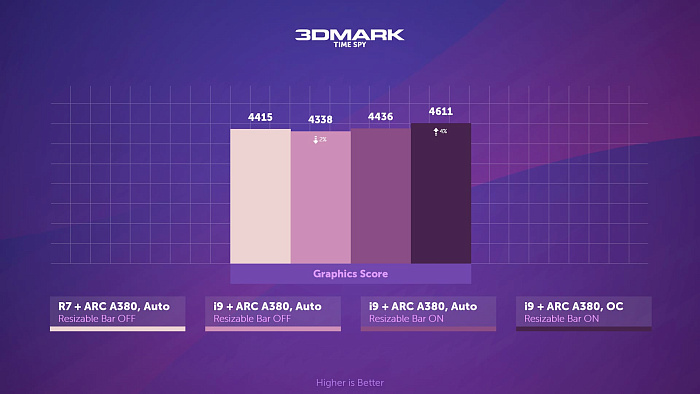

В 3Dmark Firestrike ReBar дал приличный 18% прирост, а разгон подкинул ещё 4%.

В то же время Timespy не отреагировал на ReBar, но разгон дал снова 4%.

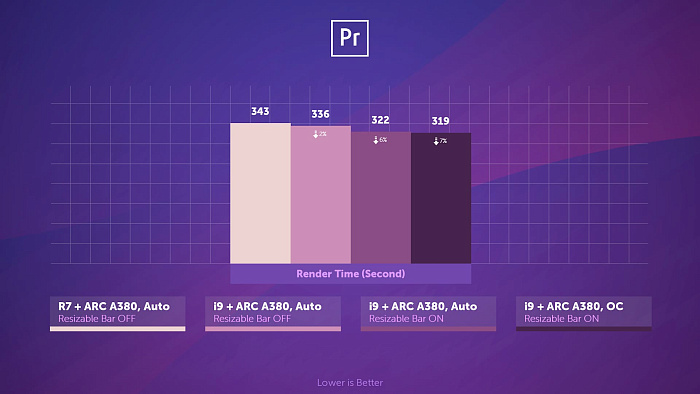

Рендер простого проекта в Adobe Premiere Pro более апатично отреагировал на изменения. Даже между крайними значениями разница всего 7%.

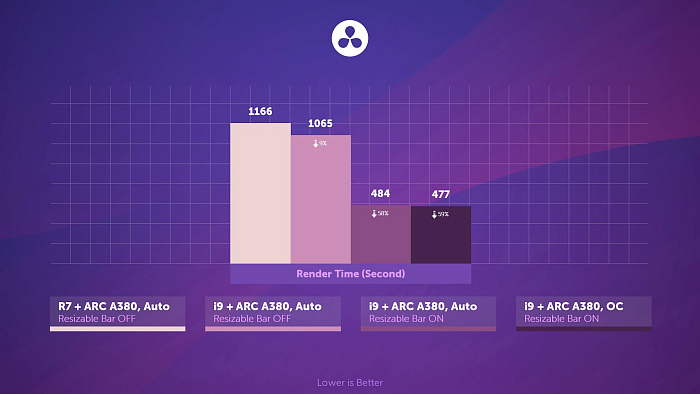

Однако Davinci Resolve более чем в 2 раза нарастил скорость рендера благодаря включенному ReBar, но и без него более высокая производительность системы на i9 дала о себе знать.

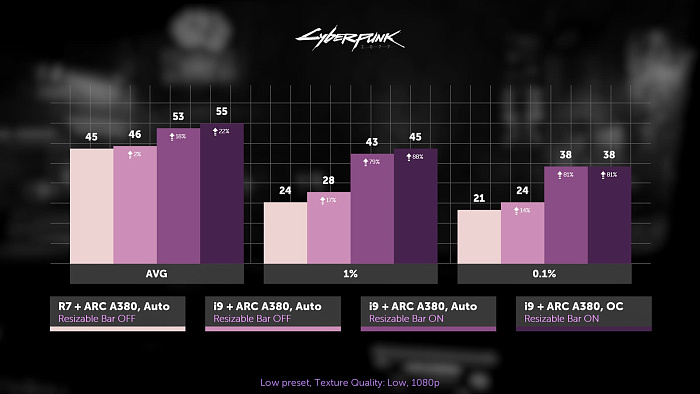

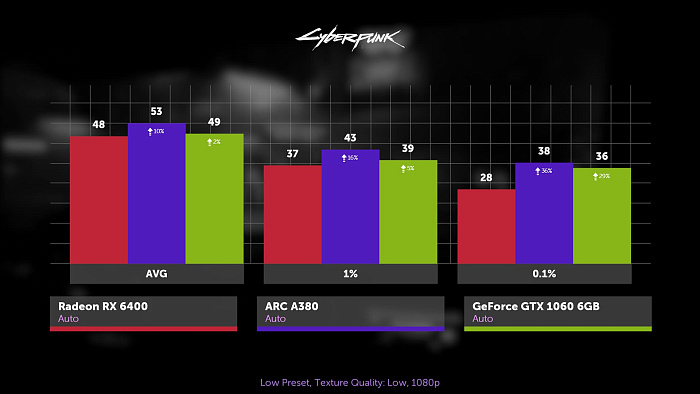

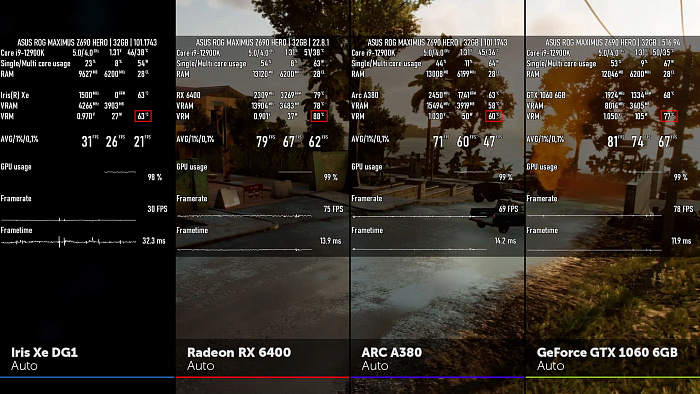

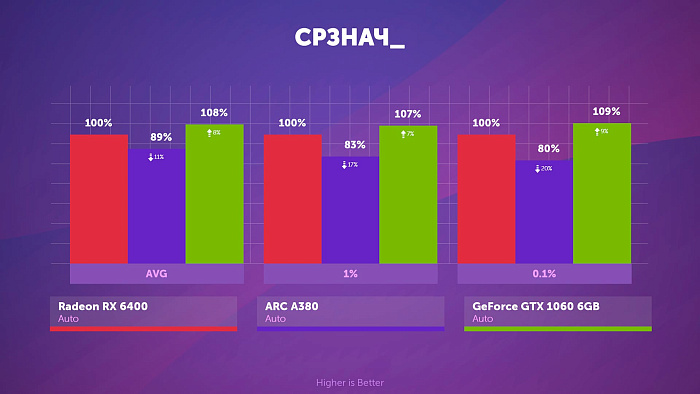

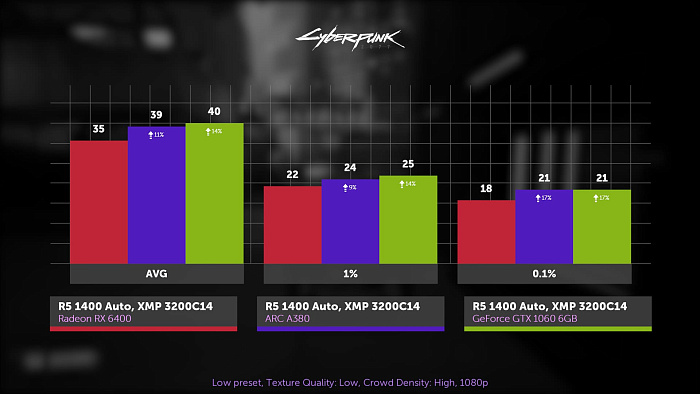

Киберпанк, пресет графики и разрешение текстур минимальные, 1080p. В сочетании с i9 средний FPS на один кадр повыше, да и статтеры послабее, однако мы не использовали SMT Patch для процессоров AMD, да и это не идёт ни в какое сравнение с приростом от Resizable Bar. Мало того, что FPS с ним вырос на 16%, так и фреймтайм стал гораздо ровнее. Разгон, в свою очередь, дал снова 4% прирост.

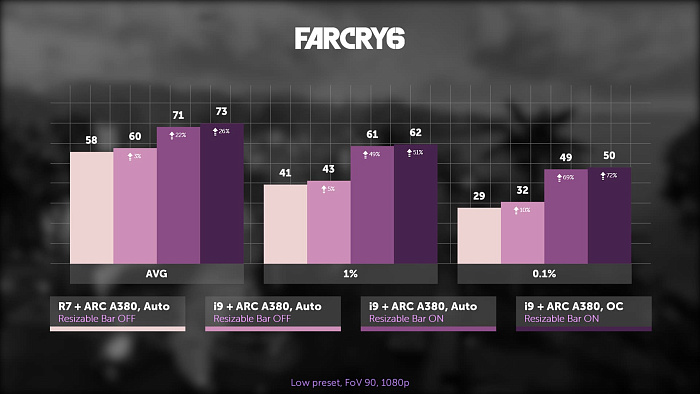

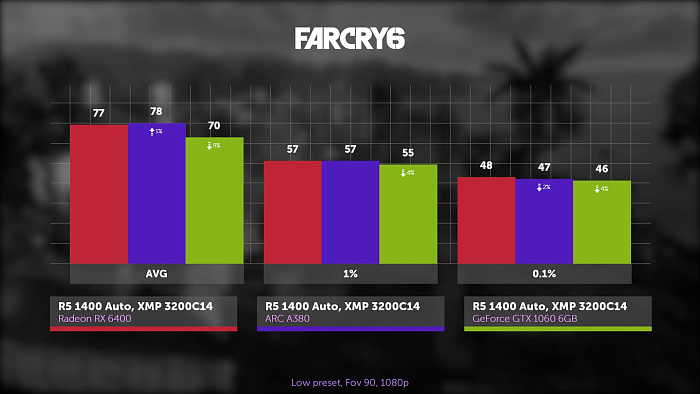

Far Cry 6, минимальный пресет, FoV 90, 1080p. Здесь всё повторяется. Без ReBar’а проскакивают статтеры и заметно ниже FPS. Разгон увеличивает средний показатель на 4%, а с AMD все показатели немного ниже.

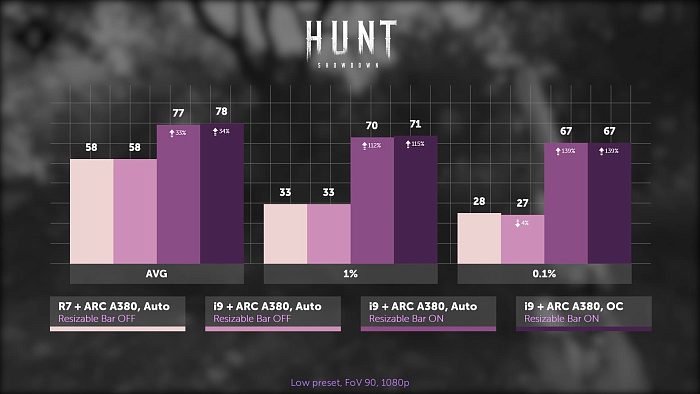

Hunt Showdown, минимальный пресет графики, FoV 90, 1080p. Здесь уже нет зависимости от того, какой процессор установлен, от красных или от синих. Главное, чтобы был ReBar, ведь с ним FPS на треть выше, да и волны статтеров беспокоить не будут.

В целом всё понятно. Если вы не можете включить ReBar, то эта видеокарта вам противопоказана. И дело не только в игровой производительности. Без него даже в винде есть зависания, особенно в браузере. Картинка замирает на пару секунд, что прилично так раздражает.

Со стендом определились. Будем использовать i9-12900K, включенный ReBar разгон убираем.

Тестовый стенд:

- Видеокарта #1: Intel Iris Xe ASUS DG1-4G

- Видеокарта #2: SHELI 51RISC AMD Radeon RX 6400

- Видеокарта #3: Intel Arc A380 GUNNIR Photon OC

- GIGABYTE Geforce GTX 1060 6GB WINDFORCE OC

- ASUS ROG Maximus Z690 Hero

- Оперативная память DDR5: T-Force Delta RGBFF3D532G6200HC38ADC01 2x16 ГБ

- Система охлаждения: Arctic Cooling Liquid Freezer II-360

- Накопитель: Crucial MX500 2 TB

- Блок питания: Deepcool PQ850M

- Корпус: BC1 Open Benchtable

- Операционная система: Windows 10

RX 6400 впервые гостит у нас на канале, поэтому давайте и с ней познакомимся.

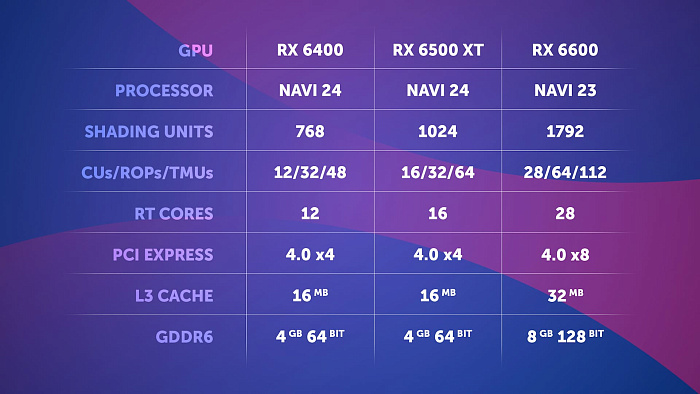

По многим параметрам она является на четверть урезанной RX 6500 XT. У неё тот же чип, но 25% всех блоков, кроме ROP’ов, забрали. Подсистема памяти пострадала только по частоте, особенно в нашем исполнении, но и на 6500 XT она была далеко не выдающейся. Всего 4 ГБ видеопамяти с узкой 64 Битной шиной, не менее ужасным PCI Express и малюсеньким infinity cache. 6500 XT уже была у нас, и мы показали, насколько фатальна для неё нехватка видеопамяти.

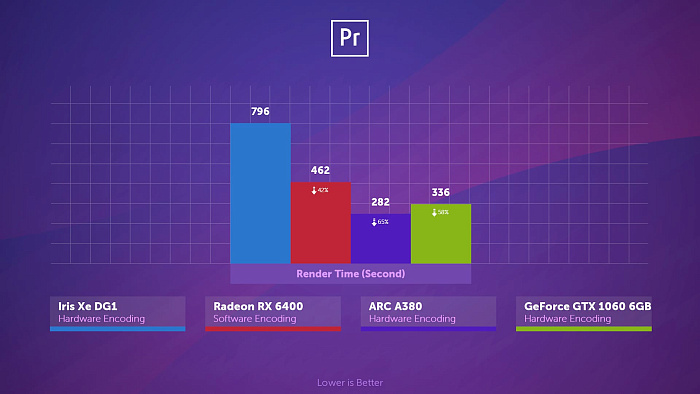

Также напомним и о максимально урезанном медиаблоке. Всё, что он позволит вам сделать, это посмотреть видео в старых кодеках. Никакого AV1, никакого аппаратного кодирования, никаких вам записей экрана. На её фоне A380 выглядит мастером на все руки.

Ещё одним ограничением является отсутствие какого-либо разгона. Ни в родном ПО, ни в MSI Afterburner, ни в More Power Tool.

Тесты в бенчмарках

Теперь к сравнению наших участников.

В GPGPU Benchmark A380 и GTX 1060 должны иметь равную скорость чтения и записи, но на ARC’е она на 20% ниже. То же самое касается DG1. Её шина остаётся загадкой, потому что из четырёх источников толкуются 4 разных сведения, но даже если мы правы, то до максимальной скорости PCI 3.0 x8 она тоже не дотягивает. По гигафлопсам A380 не впечатляет. Она на треть быстрее, чем DG1 и почти в 2 раза слабее 1060. Внутренняя скорость копирования GDDR6 идёт наравне с GDDR5 у 1060, при этом скорость вычисления 64 Битных операций значительно выше по сравнению с конкурентами. В общем, странные результаты.

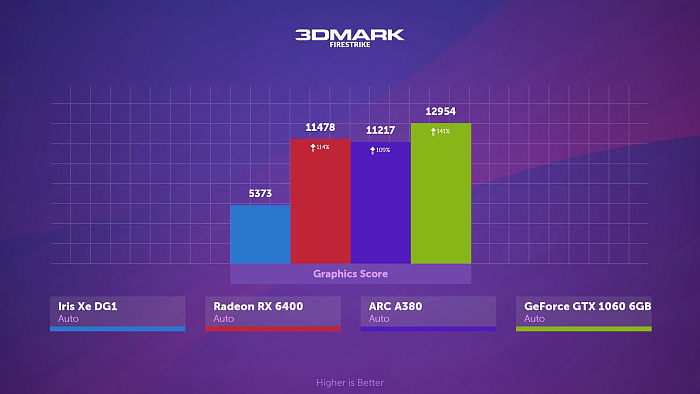

В 3DMark Fire Strike новинки идут близ друг друга, в 2 раза превосходя DG1, но 1060 на 15% быстрее их.

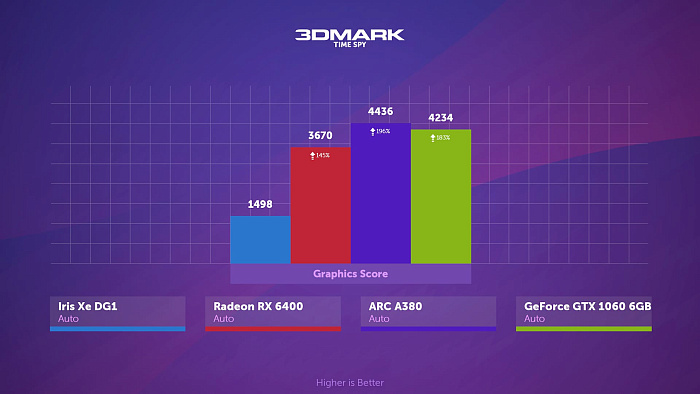

При этом в Time Spy, построенном не на DirectX 11, а на DirectX 12, 1060 уступила первенство ARC’у, но от 6400 у неё по-прежнему 15% отрыв.

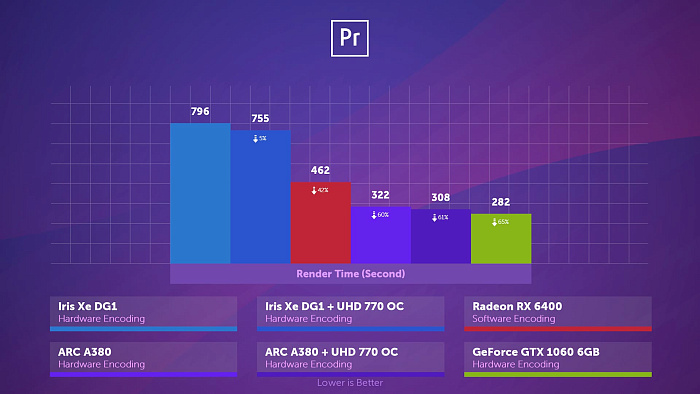

В Premiere Pro отсутствие возможности аппаратного кодирования сказывается на RX 6400, практически всю работу выполняет i9, она выступает помощником. Версия премьера на данный момент последняя, со всеми попутными оптимизациями для intel, но 1060 по-прежнему впереди.

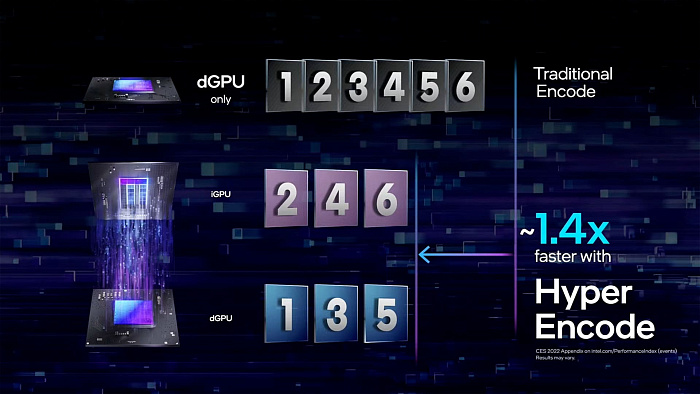

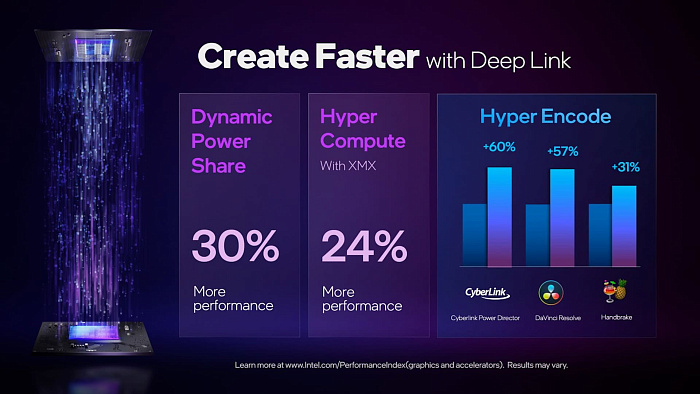

Помимо всего прочего intel представили технологию Hyper Encode, создающую синергию из дискретного и встроенного графического ядра, ускоряющего рендер до 40%. Или до 60% - они ещё не определились.

В нашем проекте вышло поменьше: +5% для DG1 и Arc A380. Причём встройка была разогнана до 2100 МГц. Ну, может, это Premiere не оптимизирован?

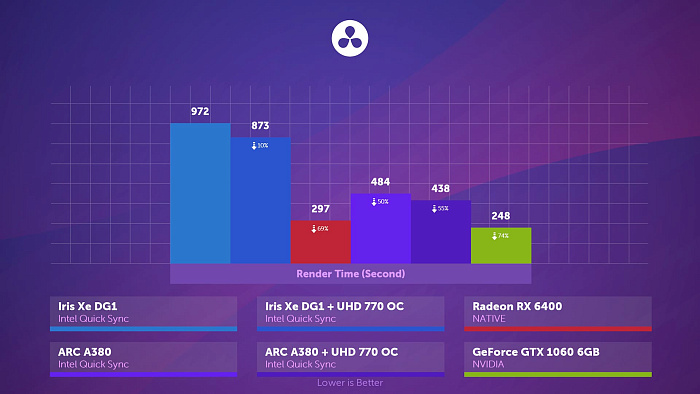

В Davinci расклад иной. Прирост от Hyper Encode составил уже 11%, но даже с этой эксклюзивной технологией A380 уступает не только 1060, но и рыксе, у которой, напомним, нет кодировщика. Конечно, с более слабым процессором у 6400 результат прилично просядет, и, что забавно, 1060 в нативном режиме, то есть без аппаратного кодирования, рендерит на 22 секунды быстрее как в Davinci, так и в Premiere, но для A380 отключение аппаратного кодировщика только замедляет рендер. То бишь 1060 до сих пор не превзошли.

Причём заторможенность медиаблока проявляется и в других аспектах. Например, в старой версии Photoshop растягивание изображения происходит с сильной задержкой, да и банальное переключение вкладок в браузере может вызывать подлагивание играющей на фоне музыки.

Возвращаемся в Киберпанк. И да, DG1 позволит вам насладиться геймплеем только в качестве зрителя. Игра почти сразу крашится в этой катсцене. На старых драйверах игра не вылетала, но там свои проблемы были. Если хотите на них посмотреть, рекомендуем глянуть наш обзор. Видеопамяти рыксе не хватает, об этом сообщает и датчик, и непостоянный FPS от прогона к прогону, выбивающийся за рамки погрешности. Причём, если глянуть на 1060, то её буфер заполнен менее чем на 3.5 Гб. Resizable Bar, к слову, на 6400 тоже включен, а на GTX по понятным причинам - нет.

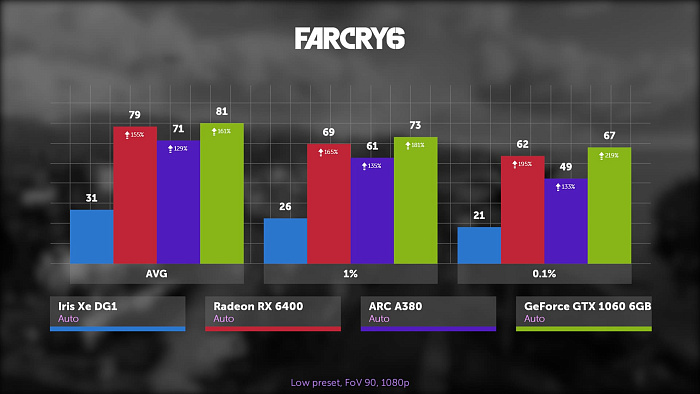

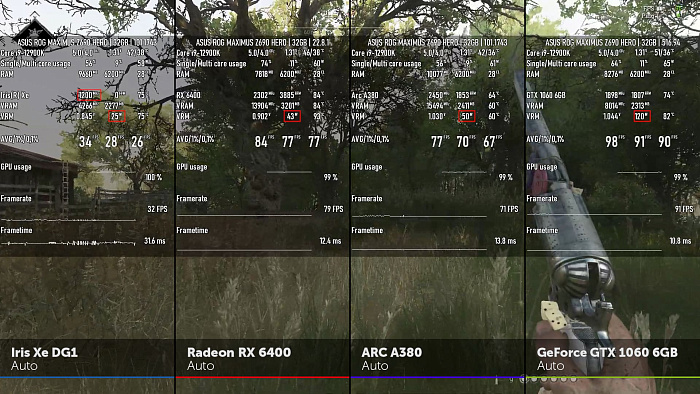

Бенчмарк Far Cry 6 на DG1 не вылетает, но играть всё равно не получится, однако, что забавно, FPS очень близок к реальному, если сравнить с последующими играми. И даже если он завышен ввиду очевидных причин, A380 отрисовывает более чем в 2 раза больше кадров. Однако в отличии от Киберпанка она утеряла первенство, причём сегодня она его уже не вернёт. Температуры в разделе VRM в случае с синими видеокартами выводится от датчика SoC, а для RX и GTX это HotSpot

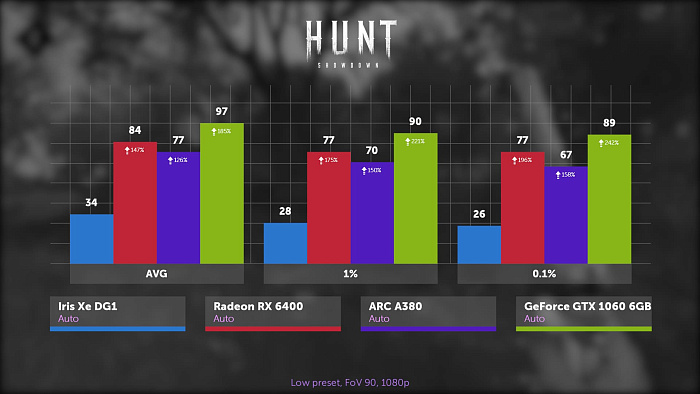

В Hunt Showdown, построенным на старой версии движка Cry Engine, использующим DirectX 11, GTX 1060 вырывается вперёд, сильно превосходя своих соперников, причём даже между отстающими RX 6400 и Arc A380 разница достигает 9% по среднему FPS не в пользу A380. Не менее любопытным является энергопотребление видеокарт. ARC потребляет в 2.5 раза меньше, чем шестилетняя 1060 и до лимита в 65 Вт ей далеко. RX при большем FPS потребляет ещё меньше, касаясь своего 43 Вт лимита. DG1 прилично сбрасывает частоты, упираясь в свой 25 Вт лимит, к сожалению, ARC Control с ней не работает.

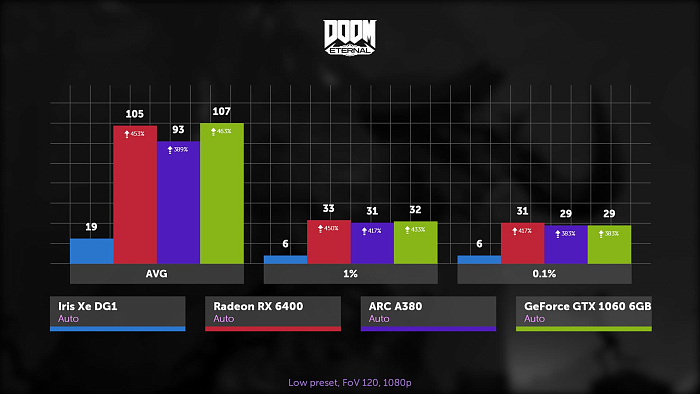

Doom Eternal, минимальный пресет графики, 1080p. DG1 снова плохо, по среднему FPS здесь привычная 2.5-кратная разница с A380, но статистика редких событий сообщает о неиграбельности. И, похоже, это происходит из-за нехватки видеопамяти 4 Гб на среднем пресете, даже рыксе не помешал бы больший буфер. В то же время снова наблюдается куда меньшее потребление видеопамяти на 1060. Игра очень хорошо идёт на видеокартах от красных, особенно с включенным ReBar, и 6400 не стала исключением. Она лидирует по всем показателям, а вот ARC снова не дотягивает.

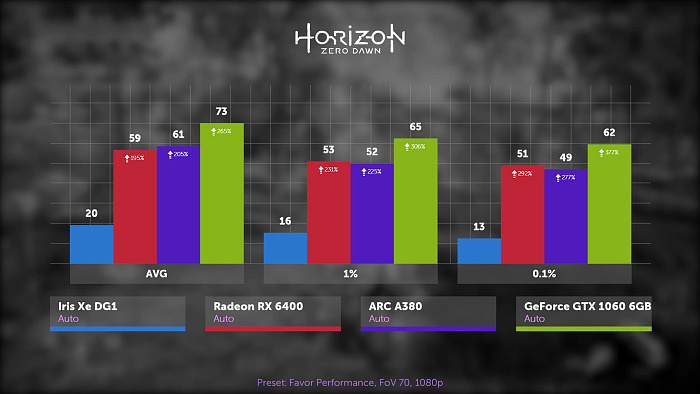

Horizon Zero Dawn, самый низкий графический пресет, FoV 70, 1080p. Игра тоже на DirectX 12, но результаты сильно отличаются от Forza 5. Рыкса на последнем месте, вполне возможно, что ей не хватает видеопамяти, а учитывая урезанный PCI Express, малейшая нехватка буфера создаст заметную просадку по FPS. 1060 снова смотрит на всех свысока. Новинки позади на 20%, а ведь 1060 легко поддаётся ещё и разгону.

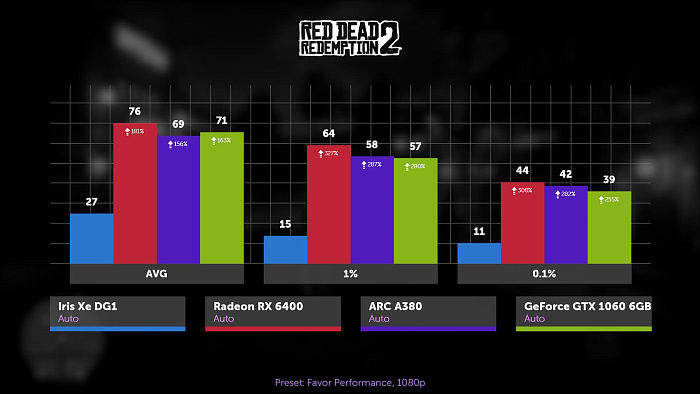

Red Dead Redemption 2, уровень пресета качества на минимум, 1080p, Vulcan. Рыкса вырвалась вперёд, второе место за GTX, ARC снова в отстающих, если судить по среднему FPS. Статистика редких и очень редких событий на ней лучше, чем на 1060, но её портят сочетания длинный-короткий кадр, не являющиеся статтерами, а скорей относящиеся к особенностям мониторинга.

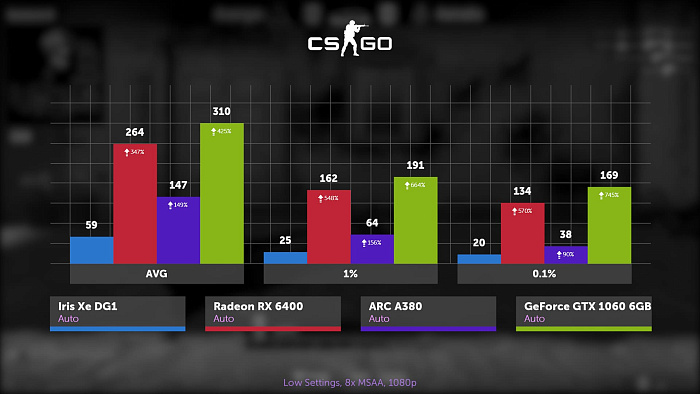

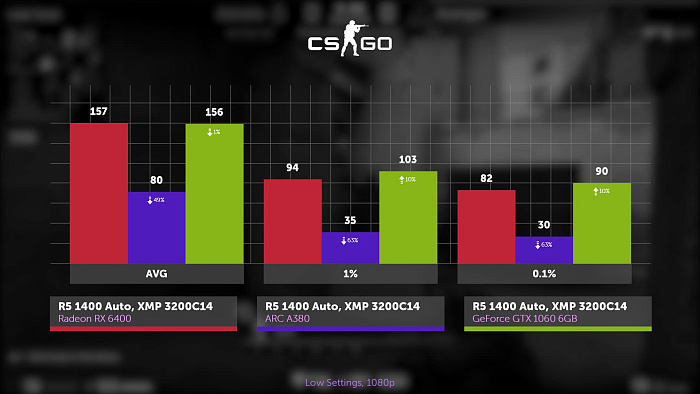

CS:GO, минимальные настройки, максимальное сглаживание, 1080p. У intel всегда были проблемы с этой игрой, или даже скорее с DirectX 9, аппаратная поддержка которого отсутствует. Недавно представители компании intel заявили, что поддержку будут эмулировать силами DirectX 12, которая по заявлениям практически неотличима от фактической реализации. Проще говоря, рано или поздно можно будет в контру без лагов поиграть, а пока спасибо, что экран не затемнён, как на DG1.

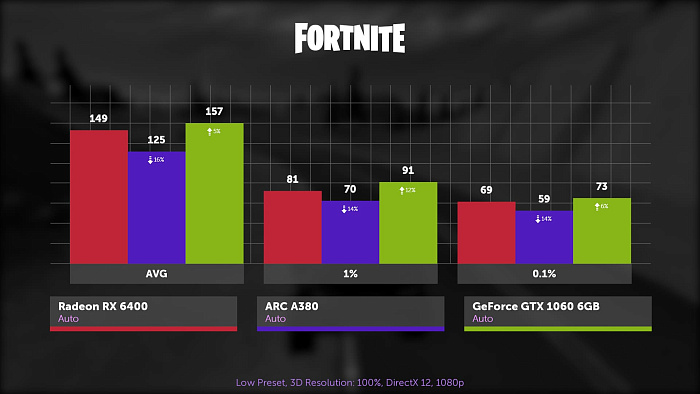

Fortnite, минимальный пресет, 1080p, DirectX 12. DG1 снова вылетает, возможно, на других API будет работать нормально. 1060 снова в лидерах, соревновательные шутеры, как правило, ей хорошо даются. ARC снова на последнем месте, а рыкса разместилась посередине. Все карточки выдают отличный FPS, но на 165 Герцовых мониторов именно с 1060 просадки будут наименее заметны.

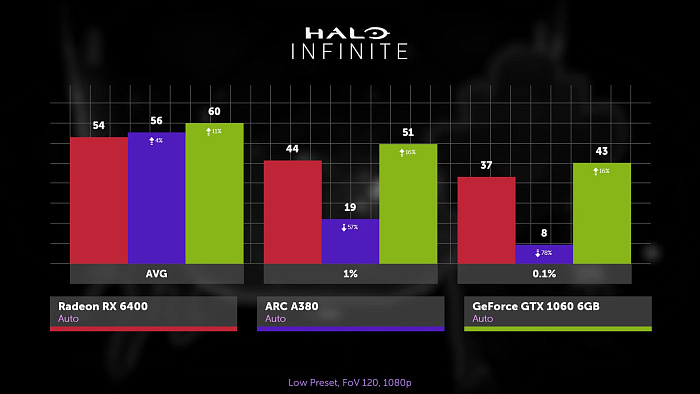

Halo Infinite, минимальный пресет, FoV 120, 1080p. Продолжая серию соревновательных шутеров, Halo привносит сюрприз. Казалось бы, игра на DirectX 12, проблем быть не должно, но они есть. Большую часть времени интеловская дискретка выдаёт больше кадров в секунду по сравнению с рыксой, но периодически или в какие-то определённые моменты FPS серьёзно проседает, и это, разумеется, видно невооружённым глазом. То есть ладно бы FPS ниже был, как в других играх, но здесь A380 единственная видеокарта, геймплей на которой можно назвать некомфортным.

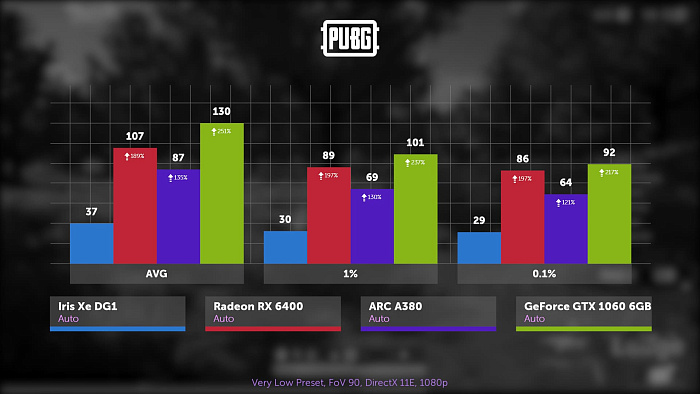

PUBG, очень низкий пресет графики, FoV 90, DirectX 11 Enhanced, Full HD. Снова 1060 в лидерах, а ARC почти в 1.5 раза отстаёт по всем показателям. Это приличная такая разница. Рыкса тоже не близка к 1060, она на 20% слабее. И выходит, что даже спустя 6 лет 1060 способна порадовать владельцев высокочастотных мониторов, а младшие карты синих и красных до сих пор не могут её превзойти.

Подводя промежуточные итоги, можно сказать, что 1060 вышла действительно хорошей видеокартой. В среднем она быстрее новинок. A380, обладая младшим чипом, с одной стороны совершила неплохой прогресс, ведь она быстрее DG1, как минимум, в 2.5 раза в играх, но местами сильно уступала сегодняшним участникам, как правило в играх на старых API, а иногда и вовсе вела себя странно, как в Halo.

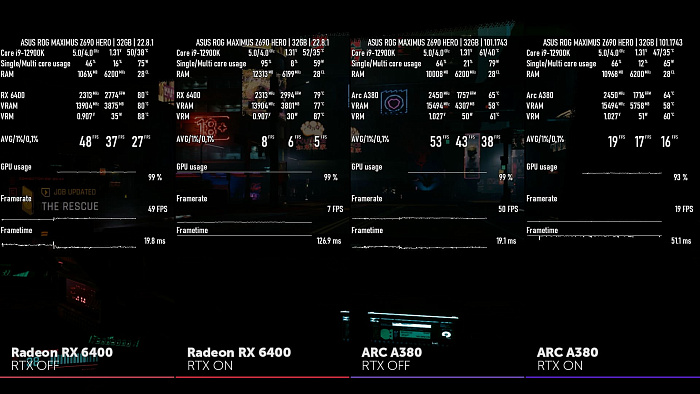

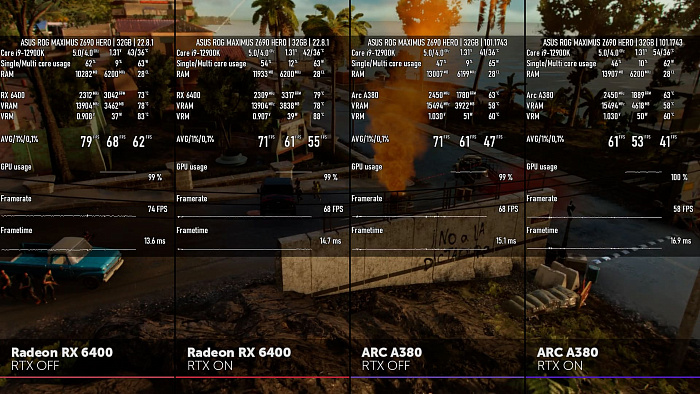

Кстати, на новинках есть RT ядра, можно взглянуть на трассировку лучей в играх. Разумеется, это баловство. Видеокарты на момент выхода едва выдают 60 FPS в современных играх на минимальных настройках, так о каких лучах может идти речь?

В Киберпанке просадка FPS ниже, чем на 6400, но та сильно страдает из-за нехватки видеопамяти, поэтому здесь нет объективности.

В Far Cry 6 играть на минималках с трассировкой, как минимум, странно. В обоих случаях теряется около 10 FPS, но в процентном соотношении для ARC потери сильнее.

В DOOM на рыксе трассировка не доступна, так что отложим эту тему до старших видеокарт.

Также интересным вопросом является производительность системы, когда упора в видеокарту нет. Многие из вас знают, что в сочетании с видеокартами Nvidia FPS с упором в процессор ниже, чем с видеокартами AMD. Это происходит, как правило, в играх на DirectX 12, и обусловлено более высокой нагрузкой на процессор от драйвера зелёных. Far Cry как раз подтверждает наши слова. Настройки те же, но дополнительно включили FSR с самым низким качеством. В сочетании с видеокартой Nvidia стоковый Ryzen 1400 с памятью в XMP успевает подготовить в среднем на 10% меньше кадров в секунду.

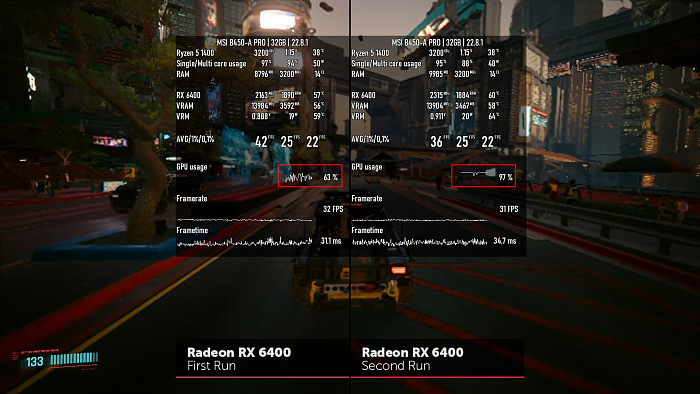

Однако Киберпанк уже демонстрирует нечто иное. В сочетании с ARC и GTX FPS почти равный, но с RX возникают проблемы, она будто залипает. Вот, для сравнения, первый и второй прогон одного и того же отрезка. Во время первого выходит тот же FPS, какой был в сочетании с A380 и 1060, но после повторной загрузки сохранения половину отрезка будто есть упор в видеокарту, хотя мы вот недавно видели, что 6400 в более сложной сцене, тем более без FSR может выдать почти в 2 раза больше FPS. И это встречается далеко не в одном Киберпанке.

В Контре отсутствие поддержки DX9 сказывается не только на видеокарте, но и процессоре. С А380 вы получаете в обоих случаях в 2 раза меньше FPS.

Заключение

Подводя итоги, скажем, что A380 по сравнению с DG1 проблем и правда имеет меньше. Новинка, как минимум, запускается с первой попытки. C DG1 нужно было даже с этим повозиться, но от предшественницы A380 перенесла немалую часть заразы. Порой может погаснуть монитор после загрузки windows или сломаться панель задач. Media Player Classic показывает чёрный экран вместо видео. Первый в списке пункт стресс-теста MSI Combustor сыпет артефактами, а также имеет место быть сильная зависимость от наличия Resizable Bar. Некоторые игры вылетают или работают ужасно. Всё это тянется с DG1 и до сих пор не исправлено. Плюсуйте к этому intel Arc Control, изобилующий багами, отваливающийся кодировщик, высокое энергопотребление в простое, которое медленно и постепенно убивает вентиляторы видеокарты. Также были замечены артефакты выводимого изображения, на красном цвете какие-то волны ходят. Не попавший в тесты Call of Duty: Warzone вылетал после заставки, пока мы не сбросили настройки графики, как и Resident Evil Village, вылетающий почти сразу после загрузки сохранения. И это мы обнаружили за каких-то пару дней.

Многие отказываются от Radeon, зачастую предлагающих в среднем близкую производительность за меньшие деньги, не столько из-за низкой производительности в RTX и отсутствия DLSS, сколько из-за менее стабильных драйверов и менее оптимизированного под красные карточки ПО. В случае с интеловскими видеокартами это в разы актуальней. И даже если их можно будет очень дешёво приобрести по сравнению с конкурентами, к ним ещё долгое время не будут относиться серьёзно.

Говоря о RX 6400, её конкурентом является GTX 1650 на GDDR6. Она выйдет дороже, по FPS они будут близки, но у 1650 есть аппаратный кодировщик, больше видеовыходов, она будет меньше терять FPS при нехватке видеопамяти. Поэтому стоит ли все эти недостатки той экономии в пользу 6400 - решать вам.